Оглавление:

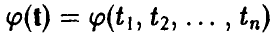

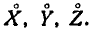

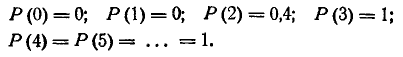

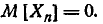

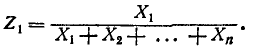

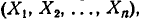

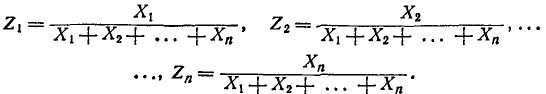

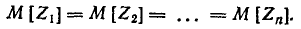

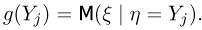

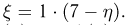

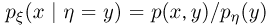

Если  — случайная величина (может быть, и векторная), наблюдаемая в эксперименте

— случайная величина (может быть, и векторная), наблюдаемая в эксперименте  , то, как мы видели выше, исчерпывающую информацию о ней дает ее закон распределения

, то, как мы видели выше, исчерпывающую информацию о ней дает ее закон распределения  . Однако довольно часто можно, описывая случайную величину, ограничиться менее подробной, чем закон распределения, информацией, указав в каком-то смысле ее характерные значения и оценив, насколько наблюдаемая случайная величина может от этих значений уклоняться. Например, если

. Однако довольно часто можно, описывая случайную величину, ограничиться менее подробной, чем закон распределения, информацией, указав в каком-то смысле ее характерные значения и оценив, насколько наблюдаемая случайная величина может от этих значений уклоняться. Например, если  — результат измерения напряжения в бытовой электросети, то сказав, что это напряжение равно 220 В с возможными отклонениями плюс-минус 40 В, мы удовлетворим подавляющее большинство запросов пользователей этой сети.

— результат измерения напряжения в бытовой электросети, то сказав, что это напряжение равно 220 В с возможными отклонениями плюс-минус 40 В, мы удовлетворим подавляющее большинство запросов пользователей этой сети.

Для некоторых случайных величин подобное описание может оказаться и неинформативным. Как правило, это происходит тогда, когда возможное рассеяние значений случайной величины оказывается значительным и соизмеримым со всем диапазоном принимаемых ею значений.

Мы рассмотрим здесь некоторые числовые показатели, называемые числовыми характеристиками случайной величины, которые отражают характерные для данной случайной величины аспекты ее поведения и позволяют описывать случайную величину в компактной форме. Важнейшими среди них являются характеристики положения, характеристики рассеяния и характеристики связи.

Характеристики положения

Неслучайные числа, дающие представление о наиболее характерных значениях, принимаемых случайной величиной, будем называть характеристиками положения. К ним относятся математическое ожидание (центр распределения), мода (наиболее вероятное значение) и медиана (срединное значение). С точки зрения теории и ее приложений, важнейшей среди перечисленных характеристик является математическое ожидание, на изучении свойств которого мы и остановимся ниже.

Математическое ожидание случайной величины

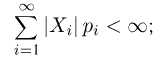

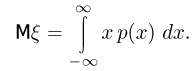

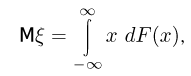

Пусть  — обобщенная плотность распределения случайной величины

— обобщенная плотность распределения случайной величины  . Математическим ожиданием, или средним, случайной величины

. Математическим ожиданием, или средним, случайной величины  назовем число, обозначаемое в дальнейшем

назовем число, обозначаемое в дальнейшем  , определяемое соотношением:

, определяемое соотношением:

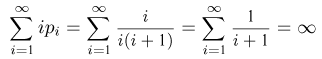

Если интеграл (1) расходится, будем говорить, что у случайной величины  математическое ожидание отсутствует.

математическое ожидание отсутствует.

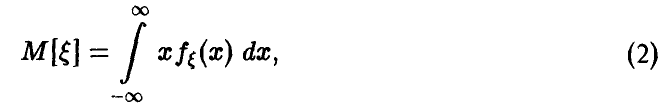

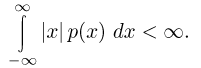

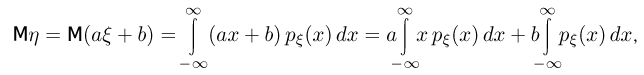

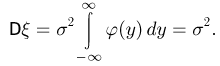

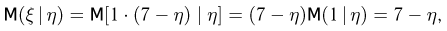

Для непрерывных случайных величин с плотностью  математическое ожидание дается равенством

математическое ожидание дается равенством

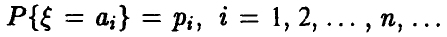

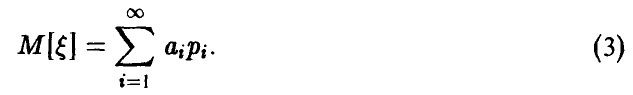

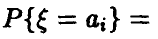

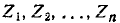

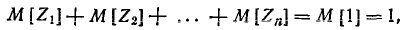

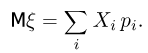

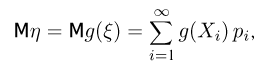

для дискретных, с рядом распределения  равенством

равенством

Если интерпретировать распределение вероятностей  как распределение единичной вероятностной массы по всей числовой прямой, то соотношения (1), (2) и (3) суть формулы для вычисления центра тяжести этой единичной массы. Именно это и имеют в виду, когда говорят, что математическое ожидание — это центр распределения.

как распределение единичной вероятностной массы по всей числовой прямой, то соотношения (1), (2) и (3) суть формулы для вычисления центра тяжести этой единичной массы. Именно это и имеют в виду, когда говорят, что математическое ожидание — это центр распределения.

Пример:

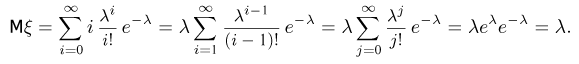

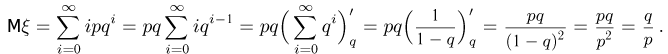

Математическое ожидание экспоненциальной случайной величины.

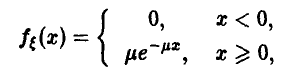

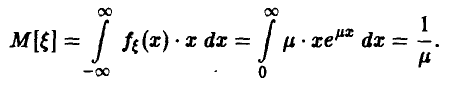

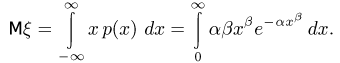

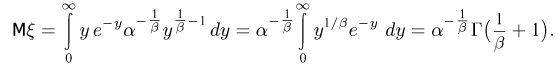

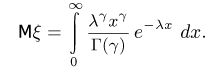

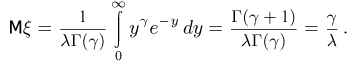

Пусть Тогда

Тогда

и для  получаем

получаем

Пример:

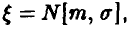

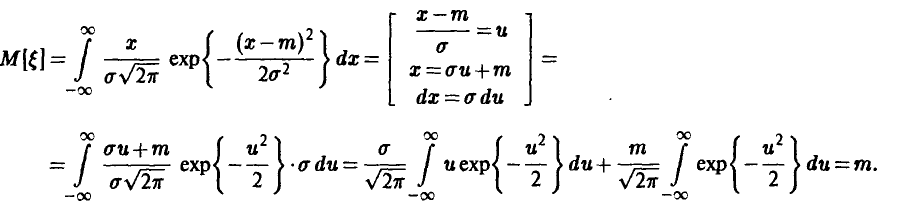

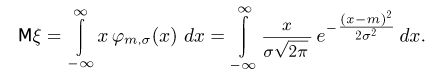

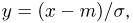

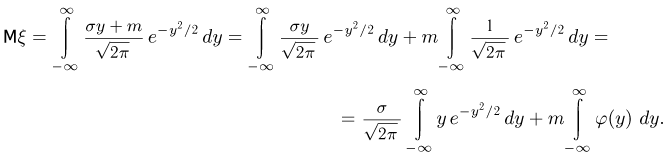

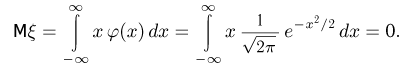

Математическое ожидание нормальной случайной величины. Пусть  т. е.

т. е.

Для  имеем

имеем

Пример:

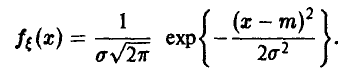

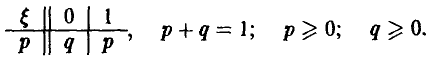

Математическое ожидание бернуллиевой случайной величины.

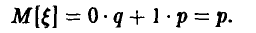

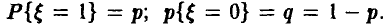

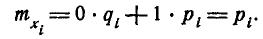

Бернуллиевая случайная величина задается рядом распределения

Для нее соотношение (3) дает

Пример:

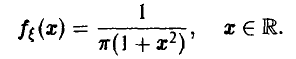

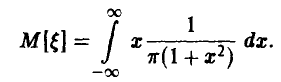

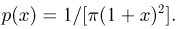

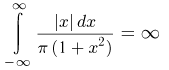

Математическое ожидание случайной величины распределенной по Коши.

Плотность распределения Коши задается соотношением

Из (2) получаем, что

Легко установить, что последний интеграл расходится. У случайной величины, распределенной по Коши, математическое ожидание не существует.

Теорема о математическом ожидании функции от случайных величин. Свойства математического ожидания

Важнейшие свойства математического ожидания являются следствиями следующей фундаментальной теоремы, которую мы примем без доказательства.

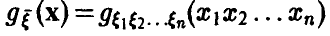

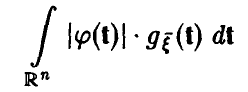

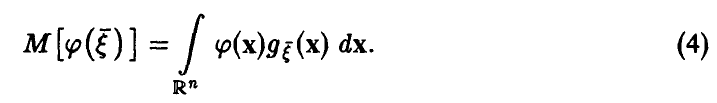

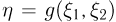

Теорема. Пусть  — случайный вектор с законом распределения

— случайный вектор с законом распределения  и функция

и функция такова, что интеграл

такова, что интеграл

сходится. Тогда

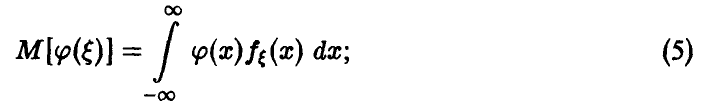

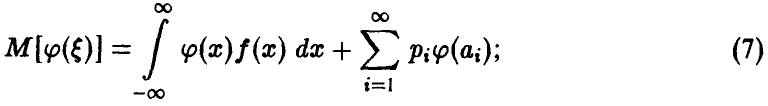

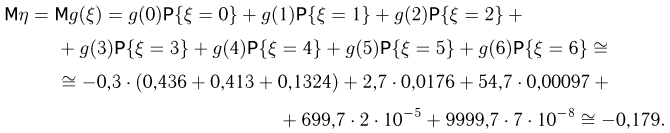

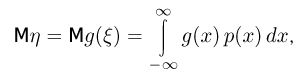

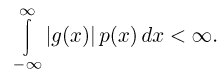

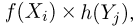

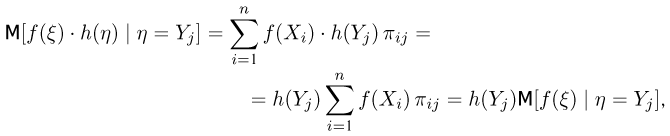

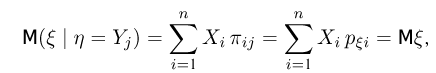

Отметим следующие, важные для дальнейшего частные случаи формулы (4): — непрерывная скалярная случайная величина с плотностью

— непрерывная скалярная случайная величина с плотностью

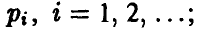

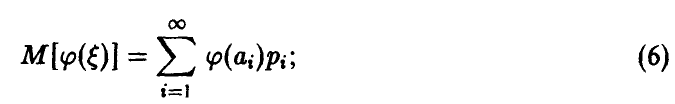

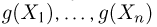

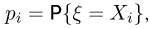

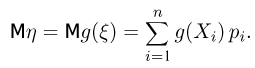

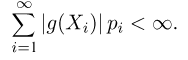

— дискретная скалярная случайная величина с рядом распределения

— дискретная скалярная случайная величина с рядом распределения

— дискретно непрерывная:

— дискретно непрерывная:

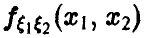

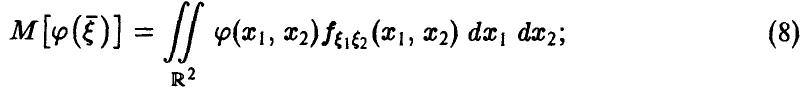

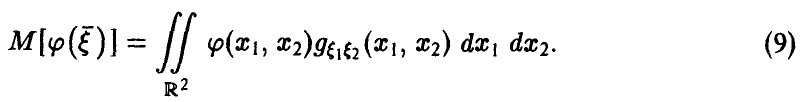

— непрерывная с плотностью

— непрерывная с плотностью

— дискретно непрерывная с обобщенной плотностью

— дискретно непрерывная с обобщенной плотностью

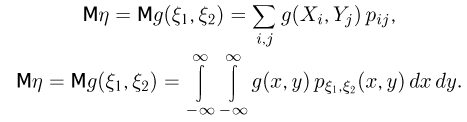

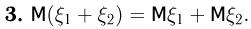

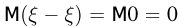

Из соотношения (4) и его вариантов (5)-(9) легко получаем следующие утверждения.

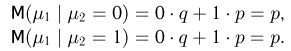

1. Математическое ожидание постоянной — постоянная

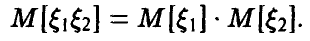

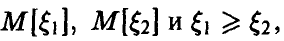

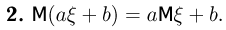

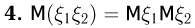

2. Если существуют  — произвольные числа, то существует

— произвольные числа, то существует  и

и

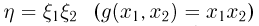

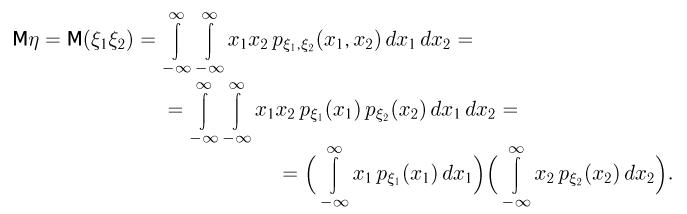

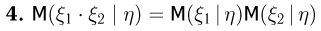

3. Если существуют  а случайные величины

а случайные величины  — независимы, то существует

— независимы, то существует  и

и

4. Если существует  неотрицательна, то

неотрицательна, то

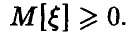

5. Если существуют  , то

, то

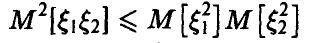

6. Если существуют  , то существует

, то существует  и

и

(неравенство Коши—Буняковского).

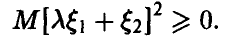

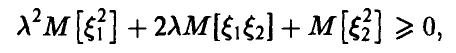

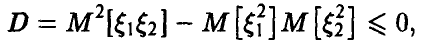

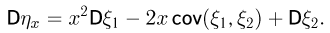

◄ Для доказательства последнего соотношения заметим, что в силу свойства 4 для любого

Откуда для всех

а это возможно лишь, если дискриминант квадратного трехчлена неположителен

откуда следует искомое. ►

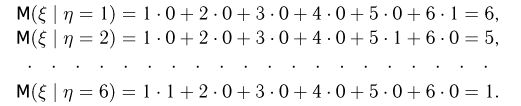

Пример:

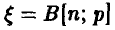

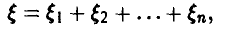

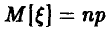

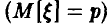

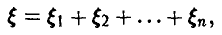

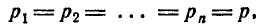

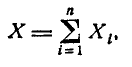

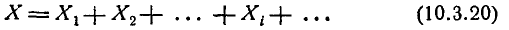

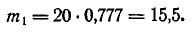

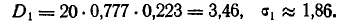

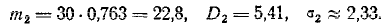

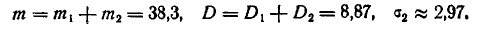

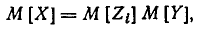

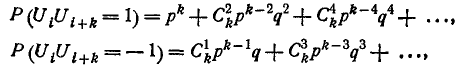

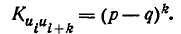

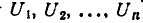

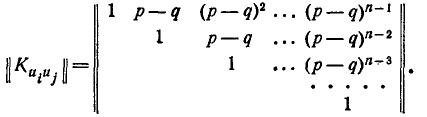

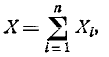

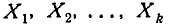

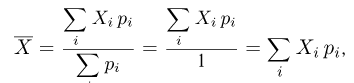

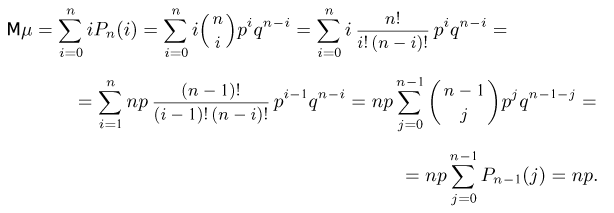

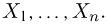

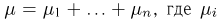

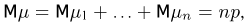

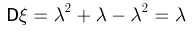

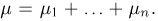

Найдем математическое ожидание биномиальной случайной величины. Напомним, что  — количество успехов в серии из n независимых испытаний с неизменной вероятностью успеха р в каждом. Поэтому

— количество успехов в серии из n независимых испытаний с неизменной вероятностью успеха р в каждом. Поэтому  представима в виде

представима в виде

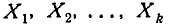

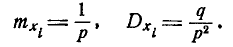

где  — независимые случайные величины с рядом распределения

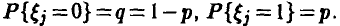

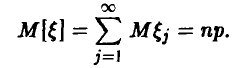

— независимые случайные величины с рядом распределения  Из свойства 2 для математического ожидания следует

Из свойства 2 для математического ожидания следует

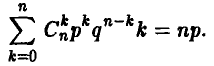

Заметим, что мы одновременно доказали комбинаторное тождество

Пример:

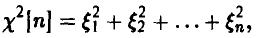

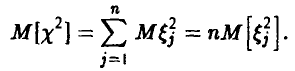

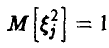

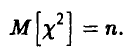

Для нахождения математического ожидания случайной величины, имеющей распределение  с n степенями свободы, воспользуемся тем же свойством 2. Так как по определению

с n степенями свободы, воспользуемся тем же свойством 2. Так как по определению

где  — независимые (0,1)-нормальные случайные величины, то

— независимые (0,1)-нормальные случайные величины, то

Из того, что  получаем окончательно

получаем окончательно

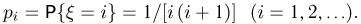

Другие характеристики положения

Коротко остановимся еще на двух числовых характеристиках положения, описывающих «характерные» значения случайной величины.

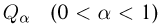

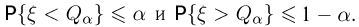

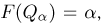

Медианой случайной величины называется число, обозначаемое в дальнейшем  и обладающее тем свойством, что

и обладающее тем свойством, что

Медиана может быть однозначно определена не для любой случайной величины. (Медиана распределения Коши равна нулю, в то время как ее математическое ожидание не существует; медиана нормального распределения и его математическое ожидание совпадают, аналогично для равномерного на [а, b] и симметричного распределения.) Медиана может и не быть одним из возможных значений случайной величины.

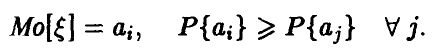

Модой случайной величины называется число, обозначаемое в дальнейшем  и обладающее тем свойством, что это наиболее вероятное значение среди всех возможных значений случайной величины.

и обладающее тем свойством, что это наиболее вероятное значение среди всех возможных значений случайной величины.

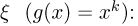

Для непрерывных случайных величин  — точка максимального значения плотности

— точка максимального значения плотности

для дискретных — значение с наибольшей вероятностью,

Если таковых (наиболее вероятных значений) у распределения несколько, то оно называется полимодальным, если оно единственно, то унимодальным. Если наибольшее значение плотности достигается в концах промежутка множества значений случайной величины, а внутри этого промежутка имеется единственный минимум, то такое распределение называется антимодальным.

Отметим, что для симметричных унимодальных распределений мода, медиана и математическое ожидание (если последнее существует) совпадают. В общем случае между перечисленными характеристиками определенных соотношений нет.

Пример:

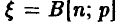

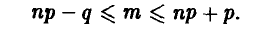

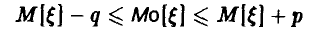

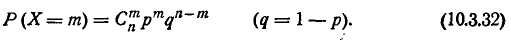

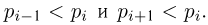

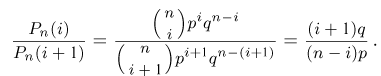

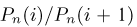

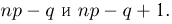

Пусть  — биномиальная случайная величина с параметрами (n,р). Если m =

— биномиальная случайная величина с параметрами (n,р). Если m =  , то по определению должны выполняться соотношения

, то по определению должны выполняться соотношения

Поэтому

откуда

Вспоминая, что  , получаем:

, получаем:

или

Из (12) следует, что мода у биномиальной случайной величины всегда есть и, при выполнении условия р(n +1) — нецелое, она единственна; если же р(n +1) — целое, то модой будут два соседних (равновероятных!) значения случайной величины

Пример:

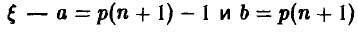

Аналогичные рассуждения для пуассоновой с параметром  случайной величины

случайной величины  приведет к неравенству

приведет к неравенству

Выводы из соотношения (13) аналогичны приведенным в вышеизложенном примере.

Характеристики рассеяния

Характеристики положения дают усредненное представление о характерных значениях, принимаемых случайными величинами. Информации в этих характеристиках тем больше, чем меньшие отклонения от них могут наблюдаться в реальном эксперименте.

Показатели, описывающие возможные отклонения значений случайной величины от «средних», называются характеристиками рассеяния. К ним относятся дисперсия, среднеквадратичное отклонение, срединное отклонение, коэффициент вариации и некоторые другие.

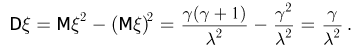

Дисперсия и ее свойства

Важнейшей из них является дисперсия.

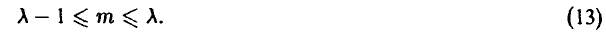

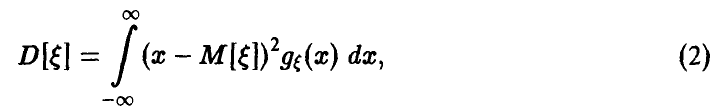

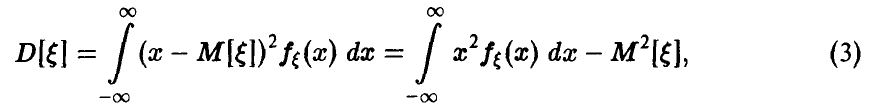

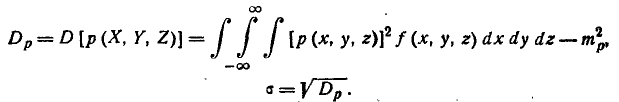

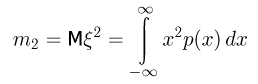

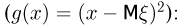

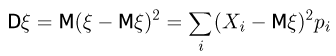

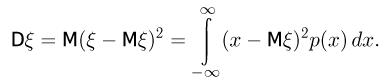

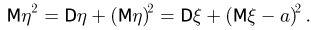

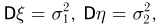

Дисперсией случайной величины  (обозначение D>[

(обозначение D>[ ]) называется математическое ожидание квадрата отклонения случайной величины

]) называется математическое ожидание квадрата отклонения случайной величины  от своего среднего

от своего среднего

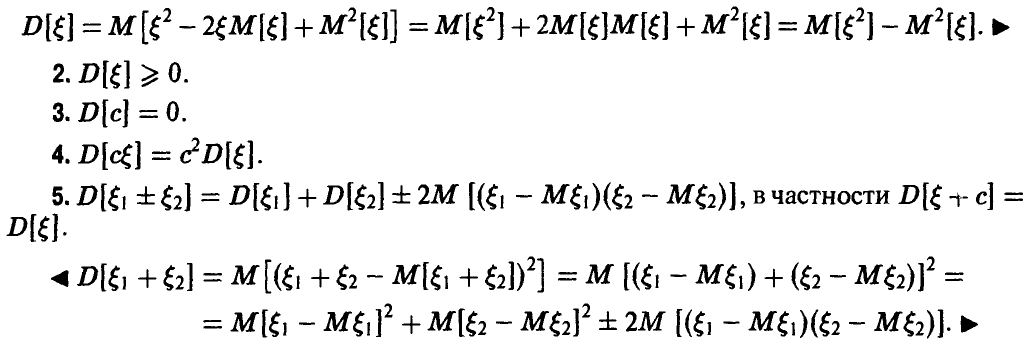

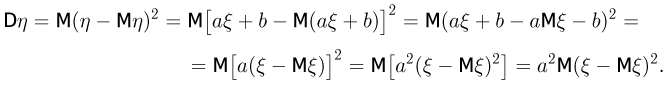

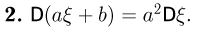

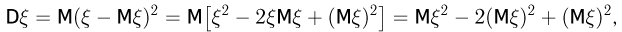

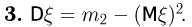

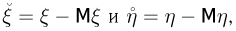

Отметим некоторые свойства дисперсии.

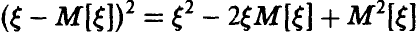

◄ Из того, что  , используя свойства математического ожидания, получаем

, используя свойства математического ожидания, получаем

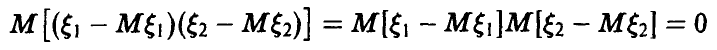

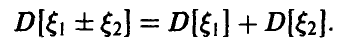

Отметим, что если случайные величины  — независимы, то из свойства 3 математического ожидания следует, что

— независимы, то из свойства 3 математического ожидания следует, что

и указанное свойство выглядит так:

6. Если  — обобщенная плотность распределения случайной величины

— обобщенная плотность распределения случайной величины  , то D[

, то D[ ] может быть вычислена из соотношения

] может быть вычислена из соотношения

в частности, если  — непрерывная случайная величина с плотностью

— непрерывная случайная величина с плотностью  , то

, то

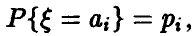

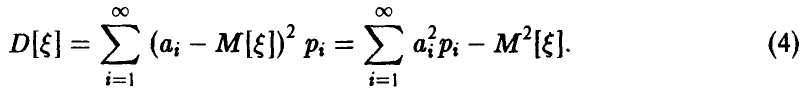

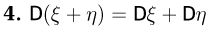

если же  — дискретная случайная величина с рядом распределения

— дискретная случайная величина с рядом распределения  то

то

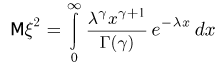

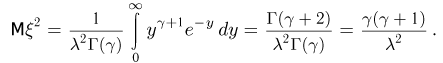

Пример:

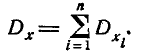

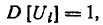

Дисперсия бернуллиевой случайной величины.

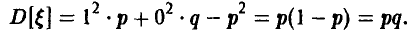

Пусть  — бернуллиева случайная величина,

— бернуллиева случайная величина,  В соответствие с соотношением (4), получаем

В соответствие с соотношением (4), получаем

Пример:

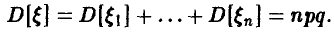

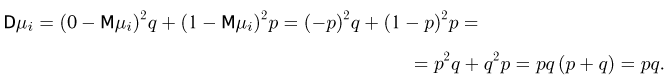

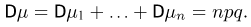

Дисперсия биномиальной случайной величины.

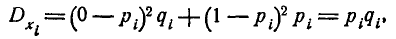

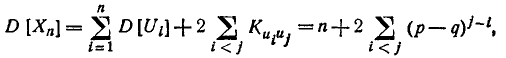

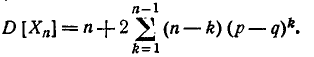

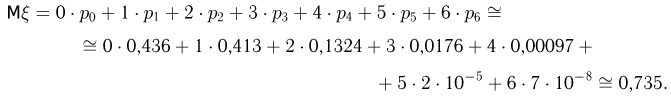

Если  — биномиальная с параметрами (n, р), то, как было отмечено выше,

— биномиальная с параметрами (n, р), то, как было отмечено выше,  представима в виде

представима в виде

где  — независимые одинаково распределенные бернуллиевы с параметром р случайные величины. Поэтому (свойство дисперсии 5)

— независимые одинаково распределенные бернуллиевы с параметром р случайные величины. Поэтому (свойство дисперсии 5)

Одновременно доказано комбинаторное тождество

Пример:

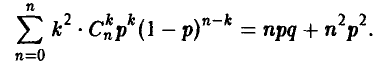

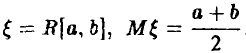

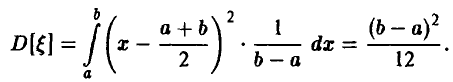

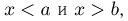

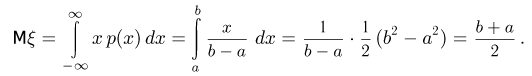

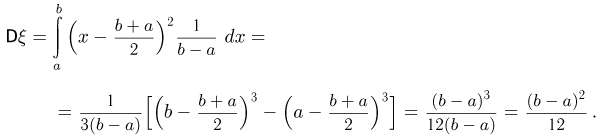

Дисперсия равномерной на [а, b] случайной величины.

Пусть  . Имеем

. Имеем

Пример:

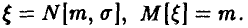

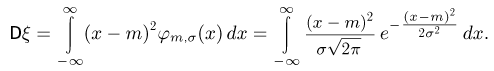

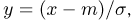

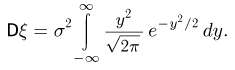

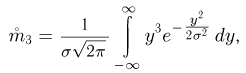

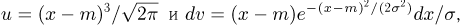

Дисперсия нормальной с параметрами  случайной величины. Пусть

случайной величины. Пусть  Тогда

Тогда

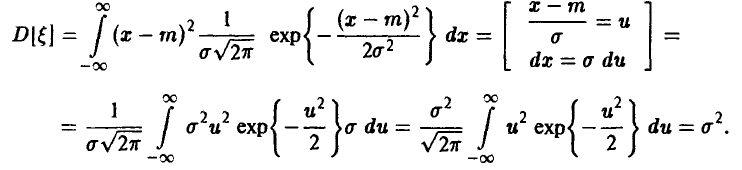

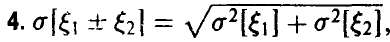

Характеристикой рассеяния, тесно связанной с дисперсией, является среднее квадратическое отклонение случайной величины:

Обладая тем же качественным наполнением (содержа в себе ту же информацию), что и дисперсия, среднее квадратическое отклонение имеет то преимущество, что измеряется в тех же единицах, что и рассматриваемая случайная величина. Отметим, что из свойств дисперсии с очевидностью следует:

если только

если только  — независимы.

— независимы.

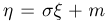

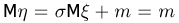

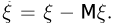

В заключение заметим, что если у случайной величины  существуют

существуют  то можно построить случайную величину

то можно построить случайную величину  , обладающую теми же свойствами, что и

, обладающую теми же свойствами, что и  , но имеющую стандартные числовые характеристики: М = 0 и D = 1. Достаточно положить

, но имеющую стандартные числовые характеристики: М = 0 и D = 1. Достаточно положить

Переход от  носит название центрирование случайной величины

носит название центрирование случайной величины  , а переход от

, а переход от  — нормирование. Таким образом, соотношение (6) описывает процедуру нормирования и центрирования случайной величины

— нормирование. Таким образом, соотношение (6) описывает процедуру нормирования и центрирования случайной величины  . Очевидно, что центрирование

. Очевидно, что центрирование  не меняет дисперсии, в то время как нормирование, носящее характер масштабного преобразования, изменяет математическое ожидание в

не меняет дисперсии, в то время как нормирование, носящее характер масштабного преобразования, изменяет математическое ожидание в  а раз.

а раз.

Неравенство Чебышева

Из определения дисперсии (1) ясно, что она призвана качественно описывать рассеяние значений случайной величины относительно математического ожидания. Точный вероятностный смысл этого описания дается неравенством Чебышева, которое мы здесь рассмотрим.

Теорема:

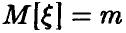

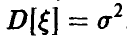

Пусть случайная величина  обладает математическим ожиданием

обладает математическим ожиданием  дисперсией

дисперсией  . Тогда каково бы ни было

. Тогда каково бы ни было

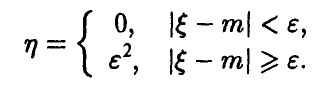

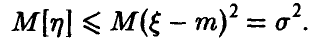

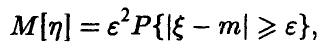

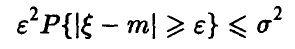

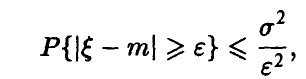

◄ Рассмотрим вспомогательную случайную величину  , заданную соотношением

, заданную соотношением

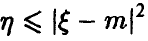

Заметим, что  , и потому

, и потому

По теореме о математическом ожидании функции от случайной величины получаем

откуда

или

чем и завершается доказательство. ►

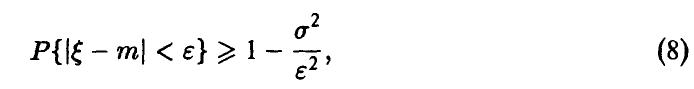

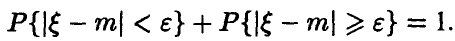

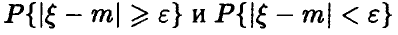

Отметим, что неравенство (7) часто используется в эквивалентной форме

получающейся из (7) применением очевидного соотношения

Неравенство Чебышева показывает, что чем меньше дисперсия, тем реже значения случайной величины  «сильно» (больше чем на

«сильно» (больше чем на  ) отклоняются от среднего m. При фиксированной дисперсии вероятности отклонений на величину, большую, чем

) отклоняются от среднего m. При фиксированной дисперсии вероятности отклонений на величину, большую, чем  , тем меньше, чем больше

, тем меньше, чем больше  .

.

Неравенство (7) универсально. Оно не предъявляет никаких требований к характеру распределения случайной величины  — достаточно существования m и

— достаточно существования m и  .

.

В силу своей универсальности оно малоинформативно количественно — для разумных значений є оценки вероятностей  крайне грубы.

крайне грубы.

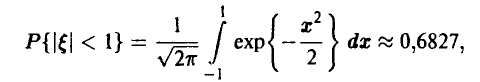

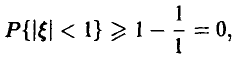

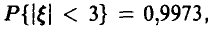

Пример:

Для нормальной случайной величины с параметрами (0, 1) имеем

в то время как неравенство Чебышёва дает

что верно, но тривиально.

Для этой же случайной величины при  точное значение вероятности

точное значение вероятности  а соотношение (8) приводит к оценке

а соотношение (8) приводит к оценке

которая уже значительно лучше предыдущей.

Несмотря на достаточно грубый характер оценок (7)-(8), без дополнительных предположений о характере распределения случайной величины  , неравенство Чебышёва, как показывает следующий пример, улучшить нельзя — оно точное.

, неравенство Чебышёва, как показывает следующий пример, улучшить нельзя — оно точное.

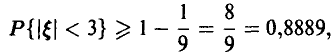

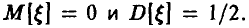

Пример:

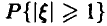

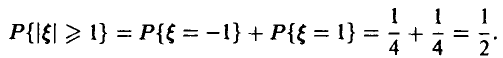

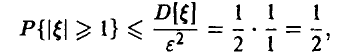

Пусть  —дискретная случайная величина, принимающая значения -1, 0 и 1 с вероятностями соответственно 1/4, 1/2, 1/4. Легко видеть, что

—дискретная случайная величина, принимающая значения -1, 0 и 1 с вероятностями соответственно 1/4, 1/2, 1/4. Легко видеть, что  Положим

Положим  и найдем значение вероятности

и найдем значение вероятности  . Имеем

. Имеем

Неравенство (7) в этой ситуации дает оценку

которая совпадает с точным значением оцениваемой вероятности.

Другие характеристики рассеяния

Из других характеристик рассеяния, часто используемых в приложениях, отметим коэффициент вариации и срединное отклонение (среднее арифметическое отклонение).

Пусть у случайной величины  существует

существует  . Коэффициентом вариации случайной величины

. Коэффициентом вариации случайной величины  называется величина

называется величина

Из (9) легко усмотреть, что  описывает рассеяние случайной величины

описывает рассеяние случайной величины  в долях по отношению к среднему. Как абсолютный показатель рассеяния коэффициент вариации не очень удобен, однако для совместно центрированных случайных величин (т. е. имеющих одинаковые математические ожидания) он позволяет эффективно сравнивать диапазоны изменения.

в долях по отношению к среднему. Как абсолютный показатель рассеяния коэффициент вариации не очень удобен, однако для совместно центрированных случайных величин (т. е. имеющих одинаковые математические ожидания) он позволяет эффективно сравнивать диапазоны изменения.

Пусть у случайной величины  существует

существует

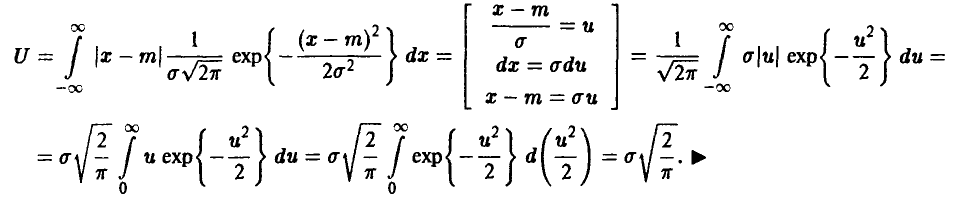

Срединным отклонением случайной величины £ называется величина U, задаваемая соотношением

Срединное отклонение  качественно имеет тот же смысл, что и среднеквадратическое отклонение — чем больше срединное отклонение, тем больше рассеяние, чем меньше срединное отклонение — тем меньше рассеяние.

качественно имеет тот же смысл, что и среднеквадратическое отклонение — чем больше срединное отклонение, тем больше рассеяние, чем меньше срединное отклонение — тем меньше рассеяние.

Для конкретных классов распределений связь между этими показателями может быть установлена, однако в общем случае удобных для использования на практике соотношений между U и  нет.

нет.

Пример:

Пусть  — нормально распределенная случайная величина. Тогда

— нормально распределенная случайная величина. Тогда

В этом случае

Пример:

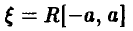

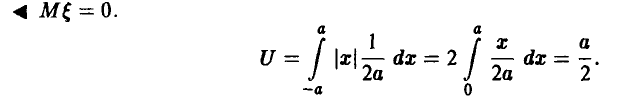

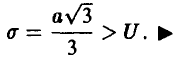

Пусть  — равномерно распределенная случайная величина. Тогда U = а/2.

— равномерно распределенная случайная величина. Тогда U = а/2.

Отметим, что и в этом случае

Замеченное свойство U <  не случайно — оно имеет место для любых случайных величин (конечно, обладающих дисперсией).

не случайно — оно имеет место для любых случайных величин (конечно, обладающих дисперсией).

Теорема:

Если у случайной величины  существует

существует  , то

, то

◄ В неравенстве Коши—Буняковского (свойство 6 математического ожидания) положим  Тогда

Тогда

откуда

Характеристики связи

Рассмотрим теперь двумерную случайную величину  с компонентами

с компонентами

. Ясно, что для решения задачи компактного описания поведения этой пары случайных величин указания средних значений компонент и характеристик их рассеяния недостаточно — здесь важную роль играют, во-первых, факт наличия или отсутствия связи между компонентами, а во-вторых, характер связи.

. Ясно, что для решения задачи компактного описания поведения этой пары случайных величин указания средних значений компонент и характеристик их рассеяния недостаточно — здесь важную роль играют, во-первых, факт наличия или отсутствия связи между компонентами, а во-вторых, характер связи.

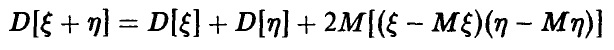

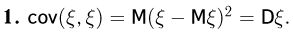

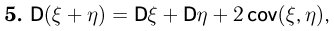

Анализ свойств математического ожидания и дисперсии показывает, что описание взаимодействия компонент случайной величины  в какой-то степени может быть получено за счет изучения величины

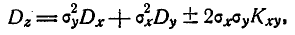

в какой-то степени может быть получено за счет изучения величины  . Действительно, вспомним, что дисперсия суммы двух случайных величин дается соотношением

. Действительно, вспомним, что дисперсия суммы двух случайных величин дается соотношением

и в случае независимости

Аналогичное положение и с математическим ожиданием произведения: в случае независимости  имеем

имеем

в противном случае

И вновь равенство  возникает как следствие независимости

возникает как следствие независимости  и

и  . Эти соображения мотивируют более тщательное изучение указанной величины с целью установления степени ее «ответственности» за независимость компонент

. Эти соображения мотивируют более тщательное изучение указанной величины с целью установления степени ее «ответственности» за независимость компонент

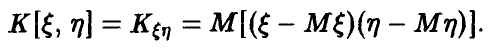

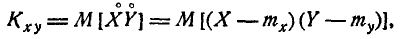

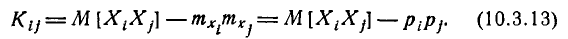

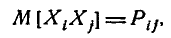

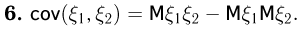

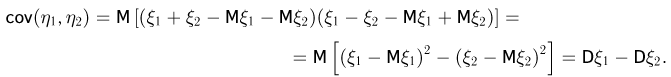

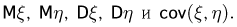

Ковариация и корреляция

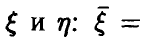

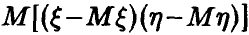

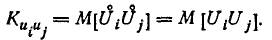

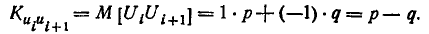

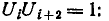

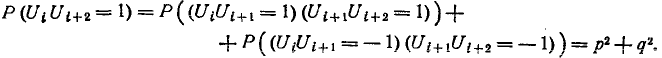

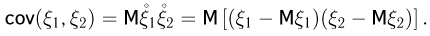

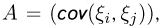

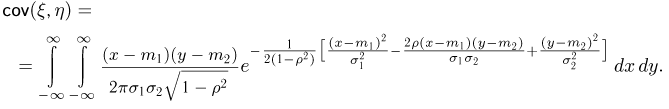

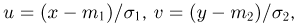

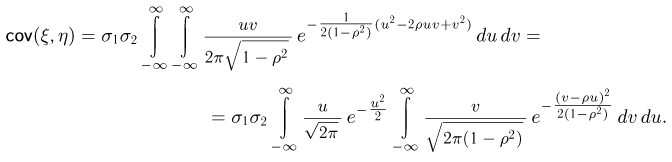

Ковариацией случайных величин  называется число

называется число

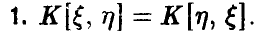

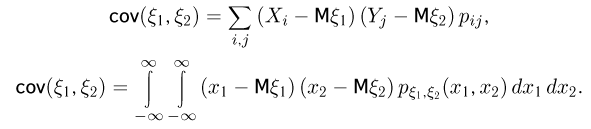

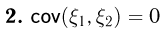

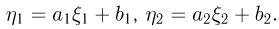

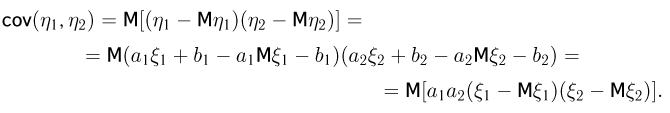

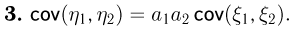

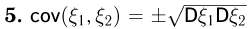

Свойства ковариации:

— обобщенный закон распределения случайной величины

— обобщенный закон распределения случайной величины

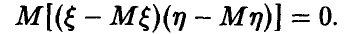

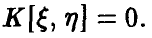

3. Если случайные величины  независимы, то

независимы, то

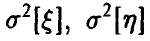

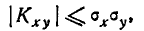

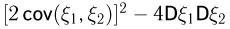

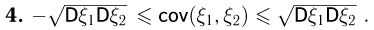

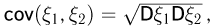

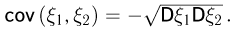

4. Если  — дисперсии случайных величин

— дисперсии случайных величин  соответственно, то

соответственно, то

◄ Последнее неравенство следует из неравенства Коши—Буняковского (свойство 6 математического ожидания). ►

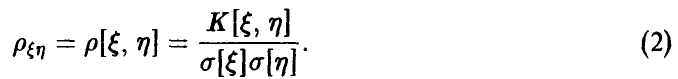

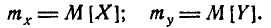

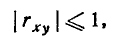

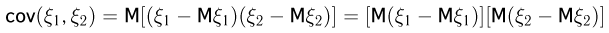

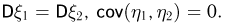

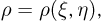

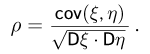

Нормированной ковариацией, или коэффициентом корреляции, случайных величин  называется число

называется число

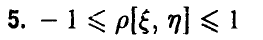

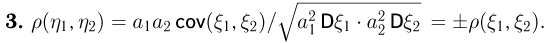

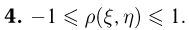

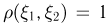

Наряду с очевидной переформулировкой отмеченных выше свойств ковариации отметим еще следующие:

◄ Очевидно следует из соотношения (1) и определения (2). ►

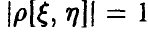

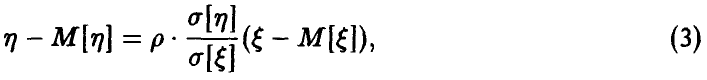

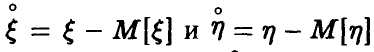

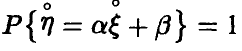

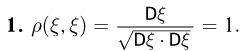

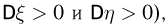

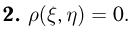

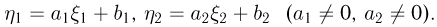

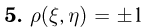

6.  тогда и только тогда, когда компоненты

тогда и только тогда, когда компоненты  линейно зависимы, при этом

линейно зависимы, при этом

где |р| = 1.

◄ Утверждение о линейной зависимости случайных величин  немедленно следует из того, что знак равенства в формуле (1) достигается в том и только в том случае, когда с вероятностью 1 случайные величины

немедленно следует из того, что знак равенства в формуле (1) достигается в том и только в том случае, когда с вероятностью 1 случайные величины  линейно связаны, т. е. существуют постоянные такие, что

линейно связаны, т. е. существуют постоянные такие, что

Взяв математическое ожидание от обеих частей последнего равенства, заключаем, что  . Для нахождения постоянной а перепишем упомянутое равенство в виде

. Для нахождения постоянной а перепишем упомянутое равенство в виде

и найдем дисперсию от обеих частей этого соотношения. Имеем

Учитывая, что  (это следует из равенства

(это следует из равенства  ), заключаем, что

), заключаем, что

Суммируя вышеизложенное, констатируем, что ковариация (коэффициент корреляции) пары случайных величин является надежным индикатором наличия между компонентами  жесткой линейной связи в случае |р| = 1. В то же время у нас нет оснований рассматривать ковариацию (коэффициент корреляции) как индикатор наличия или отсутствия какой-нибудь (не обязательно линейной) зависимости. Свойство 3 показывает, что ковариация обращается в нуль, если зависимость между

жесткой линейной связи в случае |р| = 1. В то же время у нас нет оснований рассматривать ковариацию (коэффициент корреляции) как индикатор наличия или отсутствия какой-нибудь (не обязательно линейной) зависимости. Свойство 3 показывает, что ковариация обращается в нуль, если зависимость между  отсутствует. Как свидетельствуют приводимые ниже примеры, обратное утверждение, вообще говоря, неверно.

отсутствует. Как свидетельствуют приводимые ниже примеры, обратное утверждение, вообще говоря, неверно.

Пример:

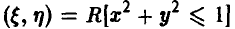

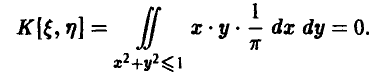

Пусть  — равномерно распределенная в круге с центром в начале координат и радиусом 1 двумерная случайная величина. Легко сообразить, что компоненты

— равномерно распределенная в круге с центром в начале координат и радиусом 1 двумерная случайная величина. Легко сообразить, что компоненты  этой случайной величины зависимы. Действительно, закон распределения одной из компонент (например, 7) зависит от значения, принятого другой: при

этой случайной величины зависимы. Действительно, закон распределения одной из компонент (например, 7) зависит от значения, принятого другой: при  = 0 диапазон изменения

= 0 диапазон изменения  от -1 до 1, при

от -1 до 1, при  = 1

= 1  принимает только нулевое значение. Ковариация же величин

принимает только нулевое значение. Ковариация же величин  , как показывают несложные выкладки, равна нулю: действительно,

, как показывают несложные выкладки, равна нулю: действительно,  и

и

Может показаться, что зависимость между  в рассмотренном примере не замечена ковариацией, потому что она (зависимость) в некотором смысле «ненастоящая». Однако следующий пример демонстрирует нам пару жестко связанных функциональной зависимостью случайных величин, ковариация которых также равна нулю.

в рассмотренном примере не замечена ковариацией, потому что она (зависимость) в некотором смысле «ненастоящая». Однако следующий пример демонстрирует нам пару жестко связанных функциональной зависимостью случайных величин, ковариация которых также равна нулю.

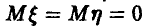

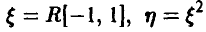

Пример:

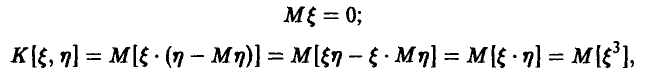

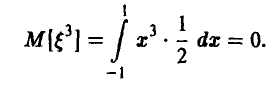

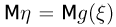

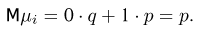

Пусть  Имеем

Имеем

но по теореме о математическом ожидании функции от случайной величины

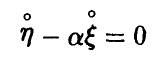

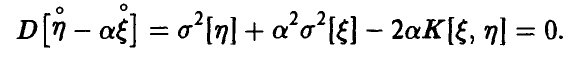

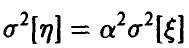

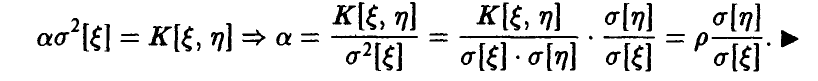

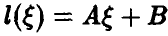

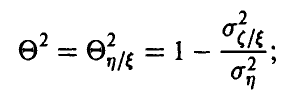

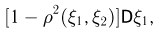

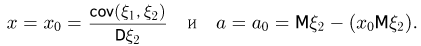

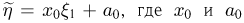

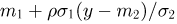

Чтобы понять роль ковариации (коэффициента корреляции) как показателя зависимости между случайными величинами  , рассмотрим следующую задачу: среди всех линейных функций от случайной величины

, рассмотрим следующую задачу: среди всех линейных функций от случайной величины  найти ту, которая наилучшим образом описывает связь между величинами

найти ту, которая наилучшим образом описывает связь между величинами  .

.

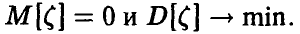

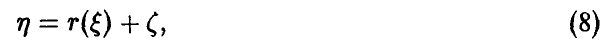

Другими словами, следует найти  такую, что

такую, что

здесь  — остаток, обладающий тем свойством, что

— остаток, обладающий тем свойством, что

Докажем следующее утверждение.

Теорема:

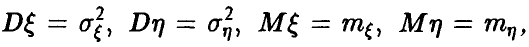

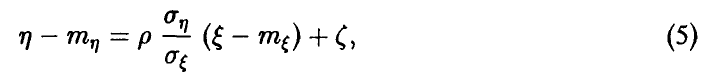

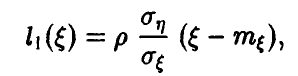

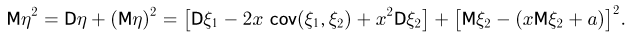

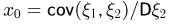

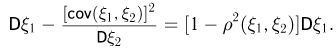

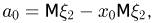

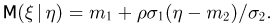

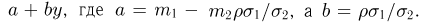

Если существуют  то соотношение (4) принимает вид

то соотношение (4) принимает вид

при этом

◄ В силу  имеем

имеем

и далее

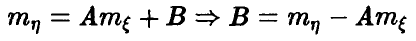

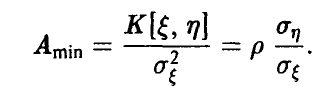

Этот квадратный (относительно А) трехчлен достигает своего наименьшего значения в точке

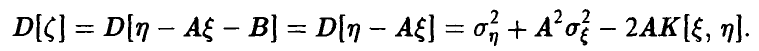

Последнее соотношение вместе с ранее полученным выражением для В и доказывает зависимость (5). Равенство (6) немедленно получается подстановкой  в выражение для

в выражение для  ►

►

Вернемся к обсуждению роли коэффициента корреляции, как показателя зависимости между случайными величинами.

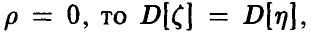

Соотношение (6) показывает, что если  а формула (5) принимает вид

а формула (5) принимает вид

т. е. линейной составляющей  в описании случайной величины

в описании случайной величины  нет и вся изменчивость случайной величины

нет и вся изменчивость случайной величины  сосредоточена в «остатке»

сосредоточена в «остатке»

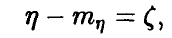

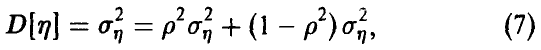

Если же  , то для дисперсии

, то для дисперсии  получаем

получаем

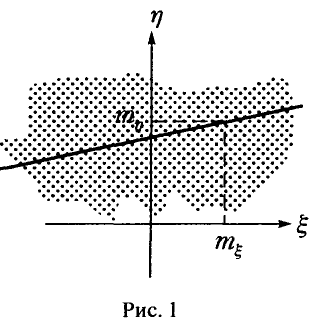

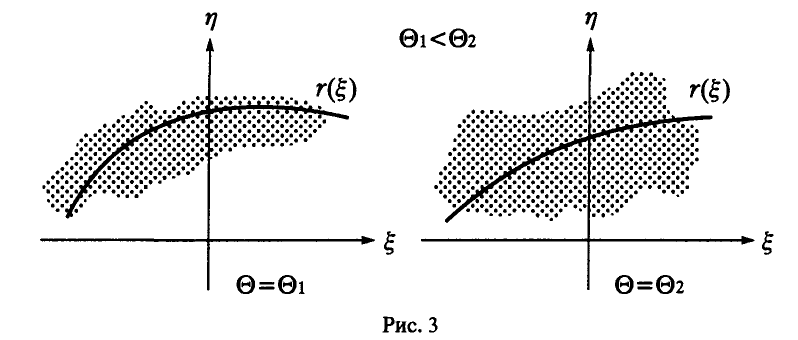

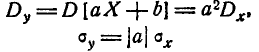

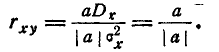

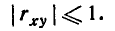

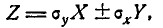

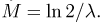

где первое слагаемое отвечает линейной составляющей зависимости (5), а второе — «остатку» Чем ближе значение р к нулю, тем хуже линейная часть (5) описывает тенденции в изменении величины  (рис. 1).

(рис. 1).

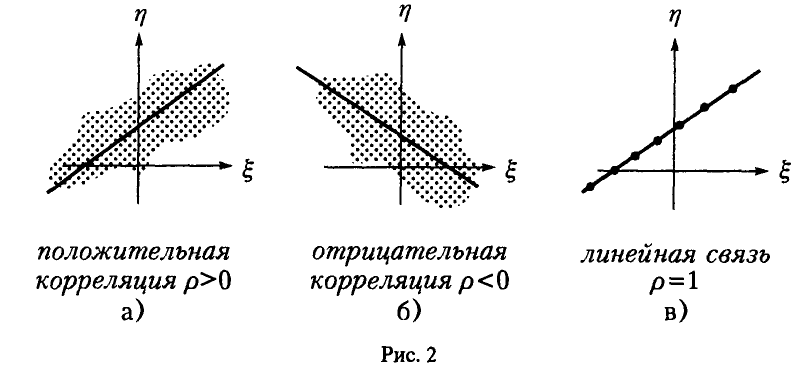

Чем ближе значение |р| к 1, тем большая часть изменчивости случайной величины  описывается линейной составляющей соотношения (5); при |р| = 1 зависимость линейная, разброса у точек

описывается линейной составляющей соотношения (5); при |р| = 1 зависимость линейная, разброса у точек  относительно прямой (5) нет, величина

относительно прямой (5) нет, величина  с вероятностью 1 равна нулю (рис. 2).

с вероятностью 1 равна нулю (рис. 2).

В случае р > 0 говорят о положительной коррелированности случайных величин  : с ростом одной из них почти линейно растет и другая, в случае р < 0 — об отрицательной (рис. 2 а, b).

: с ростом одной из них почти линейно растет и другая, в случае р < 0 — об отрицательной (рис. 2 а, b).

Окончательно заключаем: ковариация {коэффициент корреляции) является мерилом степени линейной зависимости между случайными величинами. Равенство ковариации (коэффициента корреляции) нулю свидетельствует лишь об отсутствии линейной связи между ними. Отличие ковариации (коэффициента корреляции) от нуля свидетельствует о наличии связи между случайными величинами, причем, чем ближе коэффициент корреляции к единице, тем ближе эта связь к линейной.

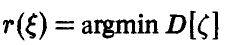

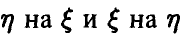

Корреляционное отношение

Для получения числовой характеристики, подобной коэффициенту корреляции, но охватывающей уже не только линейные, но и другие виды функциональных связей между случайными величинами, рассмотрим аналог задачи о представлении случайной величины  в виде (4): найдем функцию

в виде (4): найдем функцию  такую, что

такую, что

где

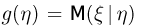

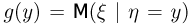

Можно показать, что решение этой задачи существует и дается так называемым условным математическим ожиданием  относительно

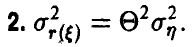

относительно  , если последнее определено. Для нас же важно, что представление (8) сопровождается аналогом дисперсионного разложения (7), а именно, дисперсия величины

, если последнее определено. Для нас же важно, что представление (8) сопровождается аналогом дисперсионного разложения (7), а именно, дисперсия величины  раскладывается в сумму двух дисперсий

раскладывается в сумму двух дисперсий  и так,что величина каждой из них описывает вклад соответствующего слагаемого соотношения (8) в изменчивость

и так,что величина каждой из них описывает вклад соответствующего слагаемого соотношения (8) в изменчивость

По аналогии с соотношением (6) введем в рассмотрение величину  такую, что

такую, что

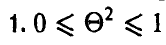

Отметим некоторые свойства показателя

◄ Следует из неотрицательности слагаемых в соотношении (9). ►

3. Если  = 0, то изменение случайной величины

= 0, то изменение случайной величины  не связано с изменением

не связано с изменением  . (Заметим, что это не означает стохастической независимости случайных величин

. (Заметим, что это не означает стохастической независимости случайных величин  (см. пример 2), а говорит лишь об отсутствии тенденции к закономерному (описываемому функциональной зависимостью) изменению

(см. пример 2), а говорит лишь об отсутствии тенденции к закономерному (описываемому функциональной зависимостью) изменению  с изменением

с изменением  .

.

4. Если  = 1, то между случайными величинами

= 1, то между случайными величинами  существует жесткая функциональная связь, описываемая функцией

существует жесткая функциональная связь, описываемая функцией  .

.

Промежуточные значения показателя  (между нулем и единицей) дают представление о ширине корреляционного поля разброса точек

(между нулем и единицей) дают представление о ширине корреляционного поля разброса точек  относительно линии

относительно линии  (рис. 3).

(рис. 3).

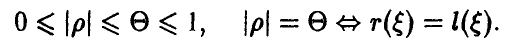

5. Если р — коэффициент корреляции пары  , то

, то

◄ Для доказательства достаточно сравнить дисперсию остатка  для

для  и линейной функции

и линейной функции  . Если

. Если  линейна, то

линейна, то  в силу (6). Если же

в силу (6). Если же  линейной функцией не является, то

линейной функцией не является, то

в силу оптимальности  , откуда следует искомое. ►

, откуда следует искомое. ►

Величина  называется корреляционным отношением, а функция

называется корреляционным отношением, а функция  линией регрессии

линией регрессии

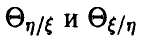

Заметим, что регрессия  — это, вообще говоря, различные линии! И корреляционное отношение

— это, вообще говоря, различные линии! И корреляционное отношение  несимметрично относительно компонент

несимметрично относительно компонент  . Величина, которую мы определили выше, является корреляционным отношением величины

. Величина, которую мы определили выше, является корреляционным отношением величины  относительно величины

относительно величины  и, чтобы подчеркнуть это обстоятельство, обычно используют следующее обозначение

и, чтобы подчеркнуть это обстоятельство, обычно используют следующее обозначение

аналогично для корреляционного отношения относительно

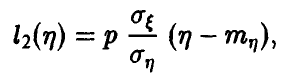

Уже в случае линейной регрессии можно было заметить, что регрессия  на

на  , задаваемая соотношением

, задаваемая соотношением

и регрессия  на

на  , задаваемая аналогичным уравнением

, задаваемая аналогичным уравнением

это различные прямые, совпадающие лишь в случае |р| = 1.

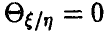

Определенных соотношений между  в общем случае нет. Как показывает рассмотренный выше пример 2, при

в общем случае нет. Как показывает рассмотренный выше пример 2, при  возможно даже

возможно даже  .

.

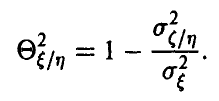

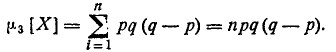

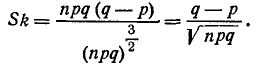

Старшие моменты. Асимметрия и эксцесс

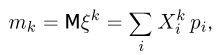

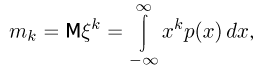

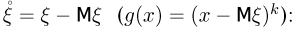

Начальным моментом случайной величины  порядка s называется число

порядка s называется число

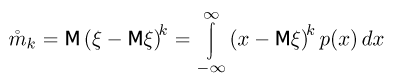

центральным моментом случайной величины  порядка s называется число

порядка s называется число

Формулы (1)-(2) имеют смысл, если соответствующие интегралы сходятся. В противном случае говорят, что моменты не существуют.

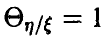

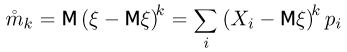

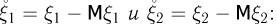

Начальные и центральные моменты связаны между собой простыми соотношениями

Со старшими моментами (порядок которых выше второго) связаны две характеристики распределения, часто использующиеся в приложениях — асимметрия и эксцесс.

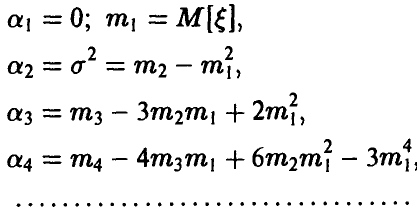

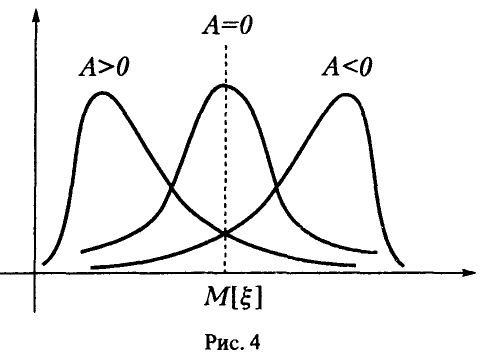

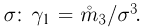

Асимметрией распределения случайной величины  называется число

называется число

Смысл асимметрии легко усматривается из формулы (3): если  — распределение имеет правую асимметрию, если

— распределение имеет правую асимметрию, если  — левую, при

— левую, при  — распределение симметрично относительно прямой

— распределение симметрично относительно прямой  (рис. 4).

(рис. 4).

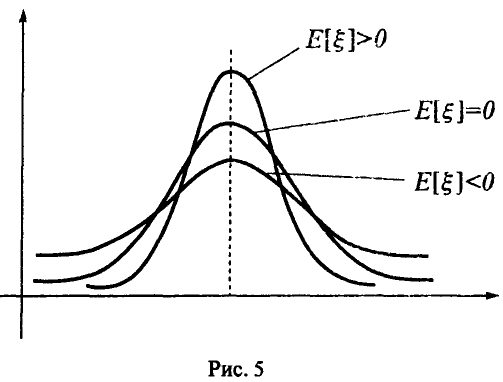

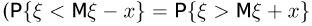

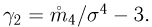

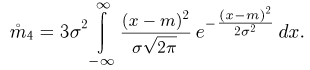

Четвертый центральный момент, нормированный четвертой степенью среднеквадратичного отклонения, называется эксцессом распределения

Эксцесс характеризует сглаженность кривой плотности распределения в сравнении со стандартным нормальным распределением (для него  ) (рис. 5).

) (рис. 5).

Однако это утверждение справедливо лишь для распределений, похожих на нормальные.

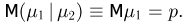

Дополнение к числовым характеристикам случайных величин

Смотрите также:

| Основные теоремы теории вероятностей | Законы распределения случайных величин |

| Случайные величины и их характеристика | Теория массового обслуживания (теория очередей). Метод Монте-Карло |

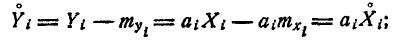

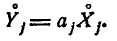

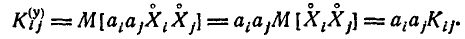

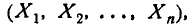

Числовые характеристики функций случайных величин

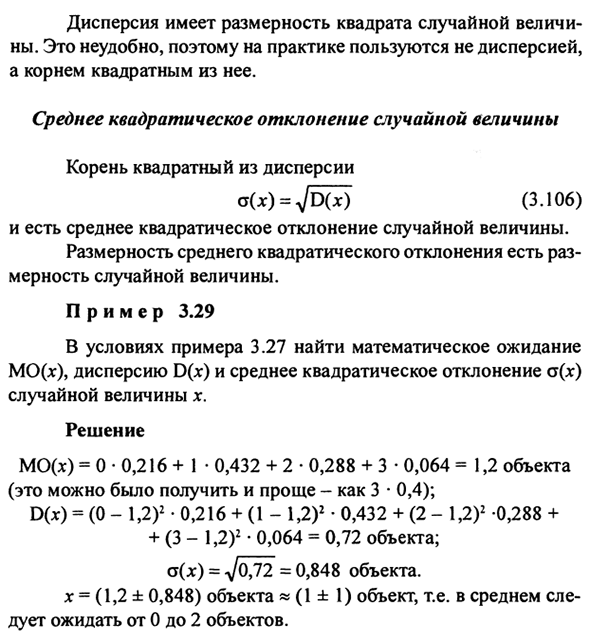

При решении различных задач, связанных со случайными явлениями, современная теория вероятностей широко пользуется аппаратом случайных величин. Для того чтобы пользоваться этим аппаратом, необходимо знать законы распределения фигурирующих в задаче случайных величин. Вообще говоря, эти законы могут быть определены из опыта, но обычно опыт, целью которого является определение закона распределения случайной величины или системы случайных величин (особенно в области военной техники), оказывается и сложным и дорогостоящим. Естественно возникает задача — свести объем эксперимента к минимуму и составлять суждение о законах распределения случайных величин косвенным образом, на основании уже известных законов распределения других случайных величин. Такие косвенные методы исследования случайных величин играют весьма большую роль в теории вероятностей. При этом обычно интересующая нас случайная величина представляется как функция других случайных величин; зная законы распределения аргументов, часто удаётся установить закон распределения функции. С рядом задач такого типа мы встретимся в дальнейшем (см. главу 12).

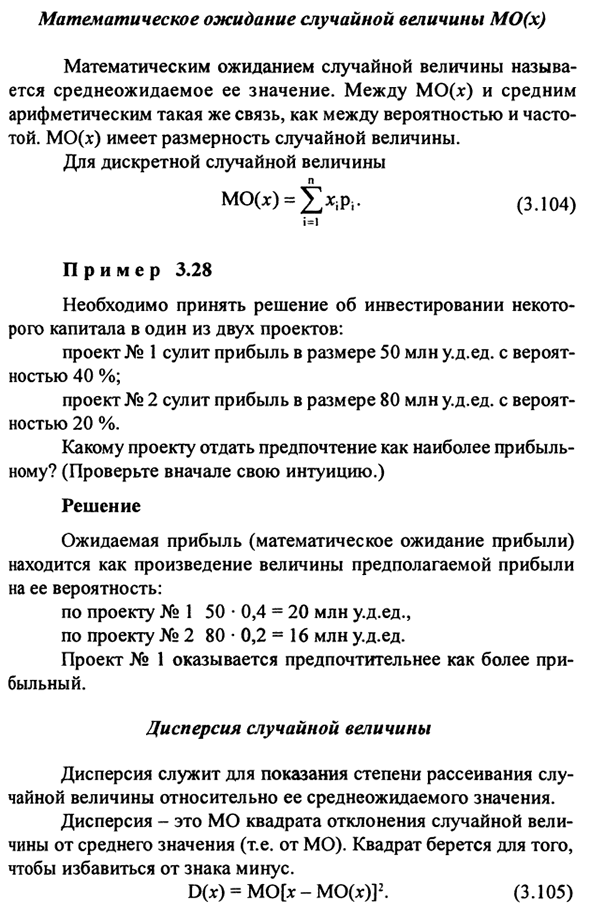

Однако на практике часто встречаются случаи, когда нет особой надобности полностью определять закон распределения функции случайных величин, а достаточно только указать его числовые характеристики: математическое ожидание, дисперсию, иногда —некоторые из высших моментов. К тому же очень часто самые законы распределения аргументов бывают известны недостаточно хорошо. В связи с этим часто возникает задача об определении только числовых характеристик функций случайных величин.

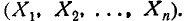

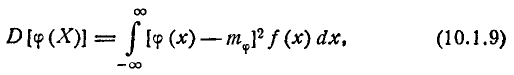

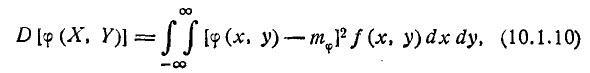

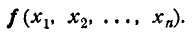

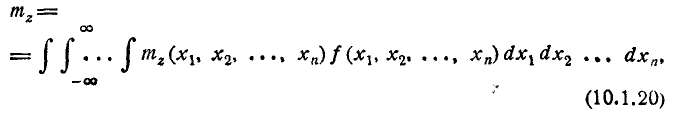

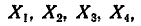

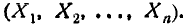

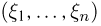

Рассмотрим такую задачу: случайная величина Y есть функция нескольких случайных величин

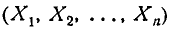

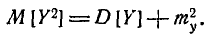

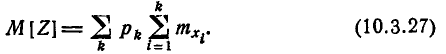

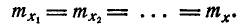

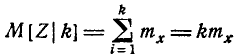

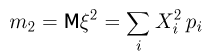

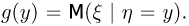

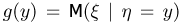

Пусть нам известен закон распределения системы аргументов  ; требуется найти числовые характеристики величины К, в первую очередь — математическое ожидание и дисперсию. Представим себе, что нам удалось тем или иным способом найти закон распределения g(y) величины У. Тогда задача об определении числовых характеристик становится тривиальной; они находятся по формулам:

; требуется найти числовые характеристики величины К, в первую очередь — математическое ожидание и дисперсию. Представим себе, что нам удалось тем или иным способом найти закон распределения g(y) величины У. Тогда задача об определении числовых характеристик становится тривиальной; они находятся по формулам:

и т. д. Однако самая задача нахождения закона распределения g(y) величины Y часто оказывается довольно сложной. К тому же для решения поставленной нами задачи нахождение закона распределения величины Y как такового вовсе и не нужно: чтобы найти только числовые характеристики величины Y , нет надобности знать её закон распределения; достаточно знать закон распределения аргументов Более того, в некоторых случаях, для того чтобы найти числовые характеристики функции, не требуется даже знать закона распределения её аргументов; достаточно бывает знать лишь некоторые числовые характеристики аргументов.

Более того, в некоторых случаях, для того чтобы найти числовые характеристики функции, не требуется даже знать закона распределения её аргументов; достаточно бывает знать лишь некоторые числовые характеристики аргументов.

Таким образом, возникает задача определения числовых характеристик функций случайных величин помимо законов распределения этих функций.

Рассмотрим задачу об определении числовых характеристик функции при заданном законе распределения аргументов. Начнём с самого простого случая — функции одного аргумента — и поставим следующую задачу.

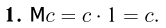

Имеется случайная величина X с заданным законом распределения; другая случайная величина У связана с X функциональной за- зависимостью:

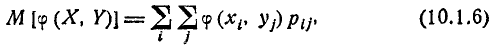

Требуется, не находя закона распределения величины У, определить её математическое ожидание:

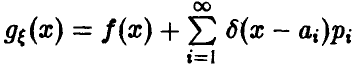

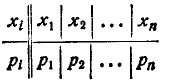

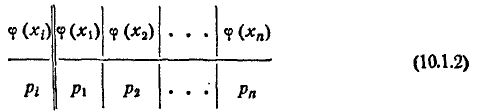

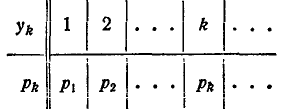

Рассмотрим сначала случай, когда Х есть прерывная случайная величина с рядом распределения:

Выпишем возможные значения величины Y и вероятности этих значений:

Таблица (10.1.2) не является в строгом смысле слова рядом распределения величины У, так как в общем случае некоторые из значений

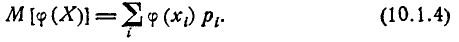

могут совпадать между собой; к тому же эти значения в верхнем столбце таблицы (10.1.2) не обязательно идут в возрастающем порядке. Для того чтобы от таблицы (10.1.2) перейти к подлинному ряду распределения величины Y, нужно было бы расположить значения (10.1.3) в порядке возрастания, объединить столбцы, соответствующие равным между собой значениям Y , и сложить соответствующие вероятности. Но в данном случае нас не интересует закон распределения величины Y как таковой; для наших целей — определения математического ожидания — достаточно такой «неупорядоченной» формы ряда распределения, как (10.1.2). Математическое ожидание величины Y можно определить по формуле

Очевидно, величина  определяемая по формуле (10.1.4), не может измениться от того, что под знаком суммы некоторые члены будут объединены заранее, а порядок членов изменён.

определяемая по формуле (10.1.4), не может измениться от того, что под знаком суммы некоторые члены будут объединены заранее, а порядок членов изменён.

В формуле (10.1.4) для математического ожидания функции не содержится в явном виде закона распределения самой функции, а содержится только закон распределения аргумента. Таким образом, для определения математического ожидания функции вовсе не требуется знать закон распределения этой функции, а достаточно знать закон распределения аргумента.

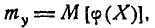

Заменяя в формуле (10.1.4) сумму интегралом, а вероятность  — элементом вероятности, получим аналогичную формулу для непрерывной случайной величины:

— элементом вероятности, получим аналогичную формулу для непрерывной случайной величины:

где f (x) — плотность распределения величины X.

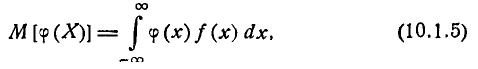

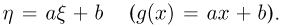

Аналогично может быть определено математическое ожидание функции  от двух случайных аргументов X и Y. Для прерывных величин

от двух случайных аргументов X и Y. Для прерывных величин

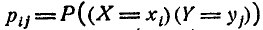

где  — вероятность того, что система (X, Y) примет значения

— вероятность того, что система (X, Y) примет значения

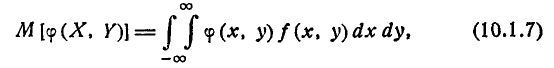

Для непрерывных величин

где f (x, у) — плотность распределения системы (X, Y).

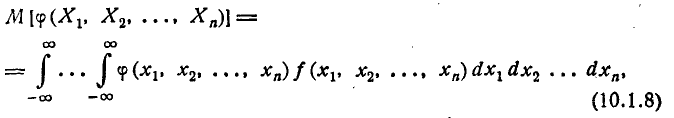

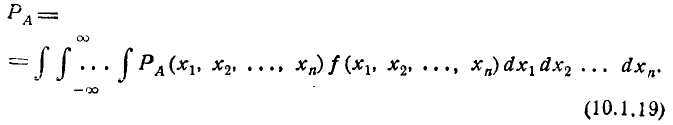

Совершенно аналогично определяется математическое ожидание функции от произвольного числа случайных аргументов. Приведём соответствующую формулу только для непрерывных величин:

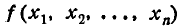

где  —плотность распределения системы

—плотность распределения системы  .

.

Формулы типа (10.1.8) весьма часто встречаются в практическом применении теории вероятностей, когда речь идёт об осреднении каких-либо величин, зависящих от ряда случайных аргументов.

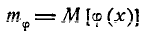

Таким образом, математическое ожидание функции любого числа случайных аргументов может быть найдено помимо закона распределения функции. Аналогично могут быть найдены и другие числовые характеристики функции — моменты различных порядков. Так как каждый момент представляет собой математическое ожидание некоторой функции исследуемой случайной величины, то вычисление любого момента может быть осуществлено приёмами, совершенно аналогичными вышеизложенным. Здесь мы приведём расчётные формулы только для дисперсии, причём лишь для случая непрерывных случайных аргументов.

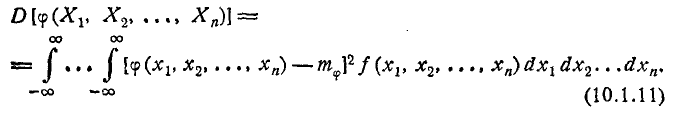

Дисперсия функции одного случайного аргумента выражается формулой

где  — математическое ожидание функции

— математическое ожидание функции  f (х) — плотность распределения величины X. Аналогично выражается дисперсия функции двух аргументов:

f (х) — плотность распределения величины X. Аналогично выражается дисперсия функции двух аргументов:

где  —математическое ожидание функции

—математическое ожидание функции  f(x у) — плотность распределения системы (X, У). Наконец, в случае произвольного числа аргументов, в аналогичных обозначениях:

f(x у) — плотность распределения системы (X, У). Наконец, в случае произвольного числа аргументов, в аналогичных обозначениях:

Заметим, что часто при вычислении дисперсии бывает удобно пользоваться соотношением между начальным и центральным моментами второго порядка (см. главу 5) и писать:

Формулы (10.1.12) — 10.1.14) можно рекомендовать тогда, когда они не приводят к разностям близких чисел, т. е. когда  сравнительно невелико.

сравнительно невелико.

Рассмотрим несколько примеров, иллюстрирующих применение изложенных выше методов для решения практических задач.

Пример:

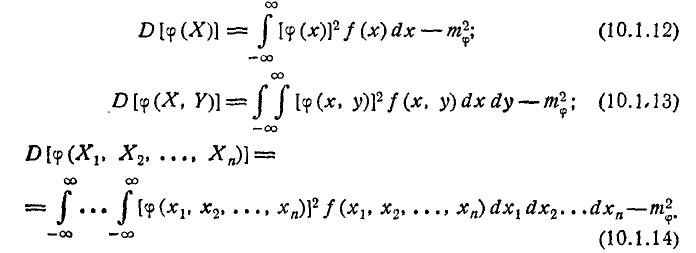

На плоскости задан отрезок длины l (рис. 10.1.1), вращающийся случайным образом так, что все направления его одинаково вероятны. Отрезок проектируется на неподвижную ось АВ. Определить среднее значение длины проекции отрезка.

Решение:

Длина проекции равна:

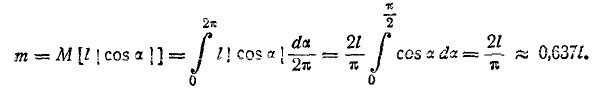

где угол а —случайная величина, распределённая с равномерной плотностью на участке  . По формуле (10.1.5) имеем:

. По формуле (10.1.5) имеем:

Пример:

Удлинённый осколок снаряда, который можно схематически изобразить отрезком длины /, летит, вращаясь вокруг центра массы таким образом, что все его ориентации в пространстве одинаково вероятны. На своём пути осколок встречает плоский экран, перпендикулярный к направлению его движения, и оставляет в нем пробоину. Найти математическое ожидание длины этой пробоины.

Решение:

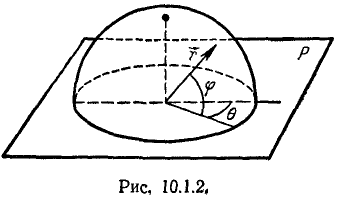

Прежде всего дадим математическую формулировку утверждения, заключающегося в том, что «все ориентации осколка в пространстве одинаково вероятны». Направление отрезка l будем характеризовать единичным вектором  (рис. 10.1.2).

(рис. 10.1.2).

Направление вектора  в сферической системе координат, связанной с плоскостью Р, на которую производится проектирование, определяется двумя углами: углом

в сферической системе координат, связанной с плоскостью Р, на которую производится проектирование, определяется двумя углами: углом  , лежащим в плоскости Р, и углом

, лежащим в плоскости Р, и углом  лежащим в плоскости, вероятности всех направлений вектора

лежащим в плоскости, вероятности всех направлений вектора  все положения его конца на поверхности сферы единичного радиуса С должны обладать одинаковой плотностью вероятности; следовательно, элемент вероятности

все положения его конца на поверхности сферы единичного радиуса С должны обладать одинаковой плотностью вероятности; следовательно, элемент вероятности

где  — плотность распределения углов

— плотность распределения углов  должен быть пропорционален элементарной площадке ds на сфере С; эта элементарная площадка равна перпендикулярной

должен быть пропорционален элементарной площадке ds на сфере С; эта элементарная площадка равна перпендикулярной

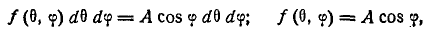

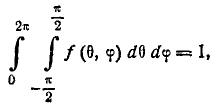

откуда

где А — коэффициент пропорциональности. Значение коэффициента А найдём из соотношения

откуда

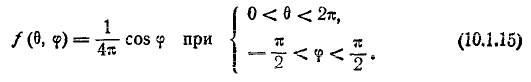

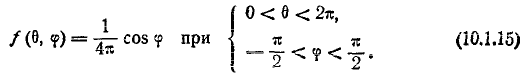

Таким образом, плотность распределения углов  выражается формулой

выражается формулой

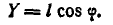

Спроектируем отрезок на плоскость Р;

Рассматривая У как функцию двух аргументов в и <р « применяя формулу (10.1.7), получим:

Таким образом, средняя длина пробоины, оставляемой осколком в экране, равна 0,785 длины осколка.

Пример:

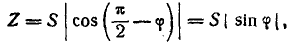

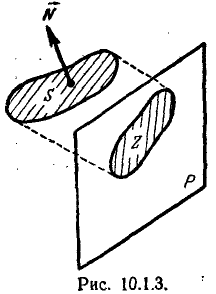

Плоская фигура площади S беспорядочно вращается в пространстве так, что все ориентации этой фигуры одинаково вероятны. Найти среднюю площадь проекции фигуры S на неподвижную плоскость Р (рис; 10.1.3).

Решение:

Направление плоскости фигуры S в пространстве будем характеризовать направлением нормали N к этой плоскости. С плоскостью Р свяжем ту же сферическую систему координат, что в предыдущем примере. Направление нормали N к площадке S характеризуется случайными углами в  и

и  распределёнными с плотностью (10.1.5). Площадь Z проекции фигуры S на плоскость Р

распределёнными с плотностью (10.1.5). Площадь Z проекции фигуры S на плоскость Р

а средняя площадь проекции

Таким образом, средняя площадь проекции произвольно ориентированной плоской фигуры на неподвижную плоскость равна половине площади этой фигуры.

Пример:

В процессе слежения радиолокатором за определённым объектом пятно, изображающее объект, все время удерживается в пределах экрана. Экран представляет собой круг К радиуса R. Пятно занимает на экране случайное положение с постоянной плотностью вероятности. Найти среднее расстояние от пятна до центра экрана.

Решение:

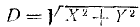

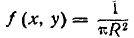

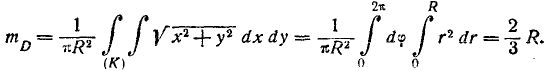

Обозначая расстояние D, имеем  , где X, Y— координаты пятна;

, где X, Y— координаты пятна;  в пределах круга К и равна нулю за его пределами. Применяя формулу 10.1.7) и переходя в интеграле к полярным координатам, имеем:

в пределах круга К и равна нулю за его пределами. Применяя формулу 10.1.7) и переходя в интеграле к полярным координатам, имеем:

Пример:

Надёжность (вероятность безотказной работы) технического устройства есть определённая функция р (X, Y, Z) трёх параметров, характеризующих работу регулятора. Параметры X, Y, Z представляют собой случайные величины с известной плотностью распределения f (х, у, z). Найти среднее значение (математическое ожидание) надёжности устройства и среднее квадратическое отклонение, характеризующее её устойчивость.

Решение:

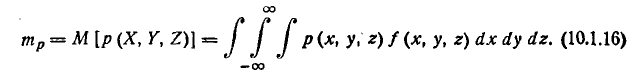

Надёжность устройства р (X, Y, Z) есть функция трёх случайных величин (параметров) X, У, Z. Её среднее значение (математическое ожидание) найдётся по формуле 10.1.8):

По формуле (10.1.14) имеем:

Формула (10.1.16), выражающая среднюю (полную) вероятность безотказной работы устройства с учётом случайных величин, от которых зависит эта вероятность в каждом конкретном случае, представляет собой частный случай так называемой интегральной формулы полной вероятности, обобщающей обычную формулу полной вероятности на случай бесконечного (несчётного) числа гипотез.

Выведем здесь эту формулу в общем виде.

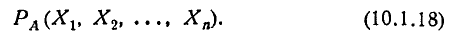

Предположим, что опыт, в котором может появиться или не появиться интересующее нас событие А, протекает в случайных, заранее неизвестных условиях. Пусть эти условия характеризуются непрерывными случайными величинами

плотность распределения которых

Вероятность  появления события А есть некоторая функция случайных величин (10.1.17):

появления события А есть некоторая функция случайных величин (10.1.17):

Нам нужно найти среднее значение этой вероятности или, другими словами, полную вероятность события А:

Применяя формулу (10.1.8) для математического ожидания функции, найдём:

Формула (10.1.19) называется интегральной формулой полной вероятности. Нетрудно заметить, что по своей структуре она сходна с формулой полной вероятности, если заменить дискретный ряд гипотез непрерывной гаммой, сумму — интегралом, вероятность гипотезы — элементом вероятности:

а условную вероятность события при данной гипотезе—условной вероятностью события при фиксированных значениях случайных величин:

Не менее часто, чем интегральной формулой полной вероятности, пользуются интегральной формулой полного математического ожидания. Эта формула выражает среднее (полное) математическое ожидание случайной величины Z, значение которой принимается в опыте, условия которого заранее неизвестны (случайны). Если эти условия характеризуются непрерывными случайными величинами

с плотностью распределения

а математическое ожидание величины Z есть функция от величин

то полное математическое ожидание величины Z вычисляется по формуле

которая называется интегральной формулой полного математического ожидания.

Пример:

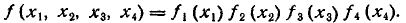

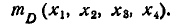

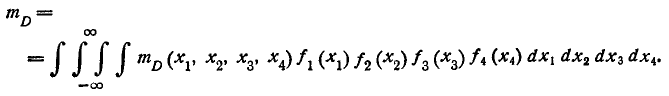

Математическое ожидание расстояния D, на котором будет обнаружен объект с помощью четырёх радиолокационных станций, зависит от некоторых технических параметров этих станций:

которые представляют собой независимые случайные величины с плотностью распределения

При фиксированных значениях параметров

математическое ожидание дальности обнаружения равно

математическое ожидание дальности обнаружения равно

Найти среднее (полное) математическое ожидание дальности обнаружения.

Решение:

По формуле (10.1.20) имеем:

Теоремы о числовых характеристиках

В предыдущем п° мы привели ряд формул, позволяющих находить числовые характеристики функций, когда известны законы распределения аргументов. Однако во многих случаях для нахождения числовых характеристик функций не требуется знать даже законов распределения аргументов, а достаточно знать только некоторые их числовые характеристики; при этом мы вообще обходимся без каких бы то ни было законов распределения. Определение числовых характеристик функций по заданным числовым характеристикам аргументов широко применяется в теории вероятностей и позволяет значительно упрощать решение ряда задач. По преимуществу такие упрощённые методы относятся к линейным функциям; однако некоторые элементарные нелинейные функции также допускают подобный подход.

В настоящем п° мы изложим ряд теорем о числовых характеристиках функций, представляющих в своей совокупности весьма простой аппарат вычисления этих характеристик, применимый в широком круге условий.

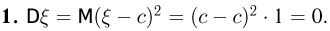

- Математическое ожидание неслучайной величины Если с — неслучайная величина, то М[с] — с.

Сформулированное свойство является достаточно очевидным; доказать его можно, рассматривая неслучайную величину с как частный вид случайной, при одном возможном значении с вероятностью единица; тогда по общей формуле для vатематического ожидания: М[с] = с*1=с.

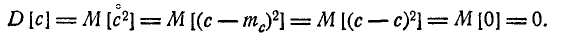

2. Дисперсия натуральной величины Если с — неслучайная величина, то D[c] = 0. Доказательство. По определению дисперсии

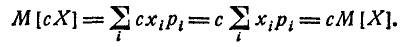

3. Вынесение неслучайной величины за знак математического ожидания Если с — неслучайная величина, а X — случайная, то М[сХ] = сМ[Х],

т. е. неслучайную величину можно выносить за знак математического ожидания.

Доказательство:

а) Для прерывных величин

б) Для непрерывных величин

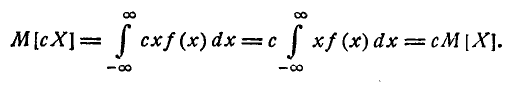

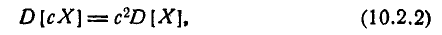

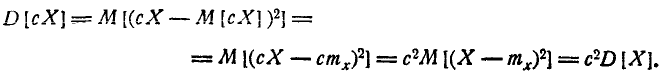

4. Вынесение неслучайной величины за знак дисперсии и среднего квадратического отклонения

Если с — неслучайная величина, а X — случайная, то

т. е. неслучайную величину можно выносить за знак дисперсии, возводя её в квадрат.

Доказательство. По определению дисперсии

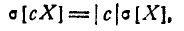

Следствие

т. е. неслучайную величину можно выносить за знак среднего квадратического отклонения её абсолютным значением. Доказательство получим, извлекая корень квадратный из формулы (10.2.2) и учитывая, что с.к.о.—существенно положительная величина.

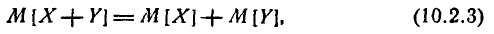

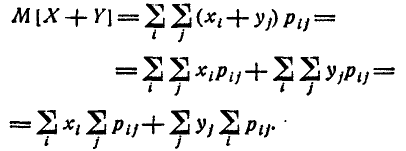

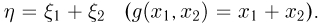

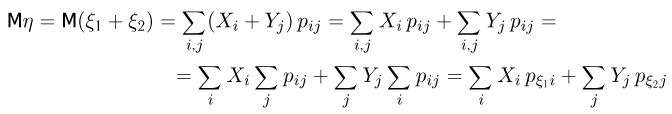

5. Математическое ожидание суммы случайных величин

Докажем, что для любых двух случайных величин X и У

т. е. математическое ожидание суммы двух случайных величин равно сумме их математических ожиданий.

Это свойство известно под названием теоремы сложения математических ожиданий.

Доказательство:

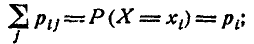

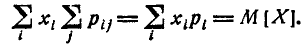

а) Пусть (X, Y) — система прерывных случайных величин. Применим к сумме случайных величин общую формулу (10.1.6) для математического ожидания функции двух аргументов:

Но  представляет собой не что иное, как полную вероятность того, что величина X примет значение

представляет собой не что иное, как полную вероятность того, что величина X примет значение

следовательно,

Аналогично докажем, что

и теорема доказана.

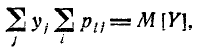

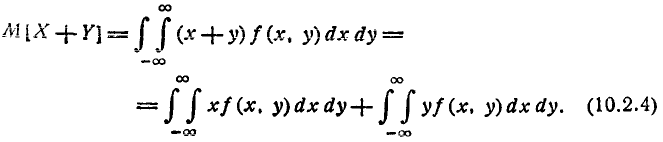

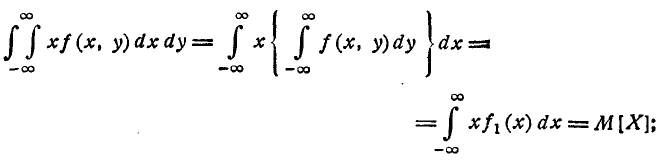

б) Пусть (X, К) — система непрерывных случайных величин. По формуле (10.1.7)

Преобразуем первый из интегралов (10.2.4):

аналогично

и теорема доказана.

Следует специально отметить, что теорема сложения математических ожиданий справедлива для любых случайных величин— как зависимых, так и независимых.

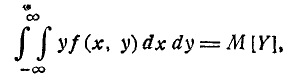

Теорема сложения математических ожиданий обобщается на произвольное число слагаемых:

т. е. математическое ожидание суммы нескольких случайных величин равно сумме их математических ожиданий.

Для доказательства достаточно применить метод полной индукции.

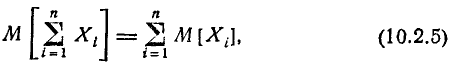

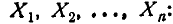

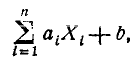

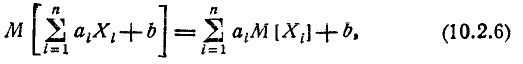

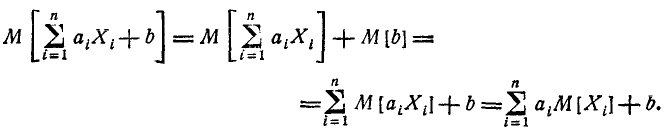

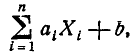

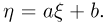

6. Математическое ожидание линейной функции Рассмотрим линейную функцию нескольких случайных аргументов

где  — неслучайные коэффициенты. Докажем, что

— неслучайные коэффициенты. Докажем, что

т. е. математическое ожидание линейной функции равно той же линейной функции от математических ожиданий аргументов.

Доказательство:

Пользуясь теоремой сложения м. о. и правилом вынесения неслучайной величины за знак м. о., получим:

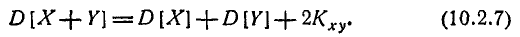

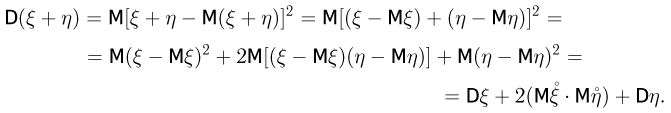

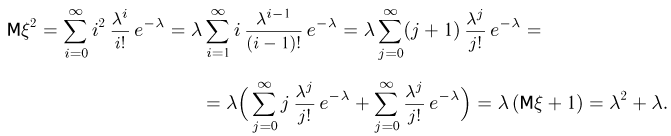

7. Дисперсия суммы случайных величин Дисперсия суммы двух случайных величин равна сумме их дисперсий плюс удвоенный корреляционный момент:

Доказательство:

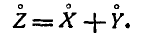

Обозначим Z = X + Y. (10.2.8)

По теореме сложения математических ожиданий

Перейдём от случайных величин X, Y, Z к соответствующим центрированным величинам  Вычитая почленно из равенства (10.2.8) равенство (10.2.9), имеем:

Вычитая почленно из равенства (10.2.8) равенство (10.2.9), имеем:

По определению дисперсии

что и требовалось доказать.

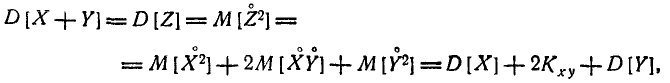

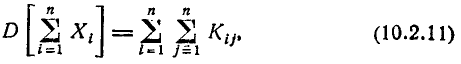

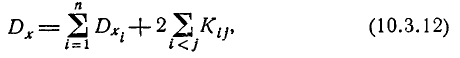

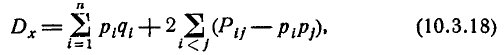

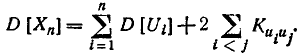

Формула (10.2.7) для дисперсии суммы может быть обобщена на любое число слагаемых:

где  — корреляционный момент величин

— корреляционный момент величин  знак

знак  под суммой обозначает, что суммирование распространяется на все в возможные попарные сочетания случайных величин

под суммой обозначает, что суммирование распространяется на все в возможные попарные сочетания случайных величин

Доказательство аналогично предыдущему и вытекает из формулы для квадрата многочлена. Формула (10.2.10) может быть записана ещё в другом виде:

где двойная сумма распространяется на все элементы корреляционной матрицы системы величин  содержащей как корреляционные моменты, так и дисперсии.

содержащей как корреляционные моменты, так и дисперсии.

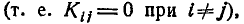

Если все случайные величины  входящие в систему, некоррелированы

входящие в систему, некоррелированы  формула (10.2.10) принимает вид:

формула (10.2.10) принимает вид:

т. е. дисперсия суммы некоррелированных случайных величин равна сумме дисперсий слагаемых. Это положение известно под названием теоремы сложения дисперсий.

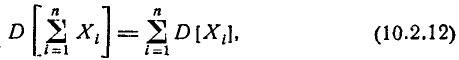

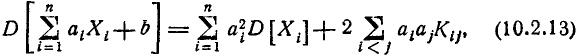

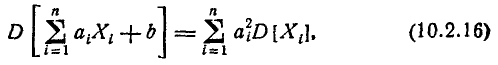

8. Дисперсия линейной функции

Рассмотрим линейную функцию нескольких случайных величин

где  — неслучайные величины.

— неслучайные величины.

Докажем, что дисперсия этой линейной функции выражается формулой

где  — корреляционный момент величин

— корреляционный момент величин

Доказательство:

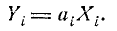

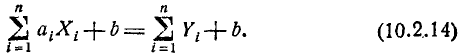

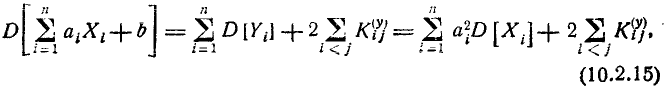

Введём обозначение:

Тогда

Применяя к правой части выражения (10.2.14) формулу (10.2.10) для дисперсии суммы и учитывая, что D [b] = 0, получим:

где  — корреляционный момент величин

— корреляционный момент величин

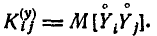

Вычислим этот момент. Имеем:

аналогично

Отсюда

Подставляя это выражение в (10.2.15), приходим к формуле (10.2.13). В частном случае, когда все величины  некоррелированны, формула (10.2.13) принимает вид:

некоррелированны, формула (10.2.13) принимает вид:

т.е. дисперсия линейной функции некоррелированных случайных величин равна сумме произведений квадратов коэффициентов на дисперсии соответствующих аргументов

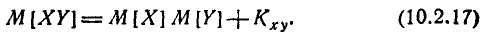

9.Математическое ожидание произведения случайных величин

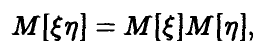

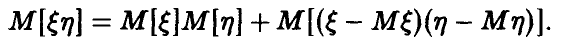

Математическое ожидание произведения двух случайных величин равно произведению их математических ожиданий плюс корреляционный момент:

Доказательство:

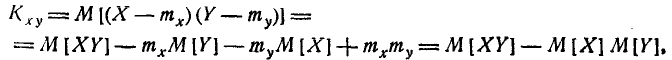

Будем исходить из определения корреляционного момента:

где

Преобразуем это выражение, пользуясь свойствами математического ожидания:

что, очевидно, равносильно формуле (10.2.17),

Так как независимые величины всегда являются некоррелированными, то все свойства, доказываемые в данном п° для некоррелированных величин, справедливы для независимых величин.

Так как независимые величины всегда являются некоррелированными, то все свойства, доказываемые в данном п° для некоррелированных величин, справедливы для независимых величин.

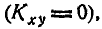

Если случайные величины (X, Y) некоррелированны  то формула (10.2.17) принимает вид:

то формула (10.2.17) принимает вид:

т. е. математическое ожидание произведения двух некоррелированных случайных величин равно произведению их математических ожиданий.

Это положение известно под названием теоремы умножения математических ожиданий.

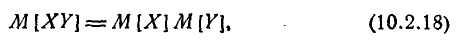

Формула (10.2.17) представляет собой не что иное, как выражение второго смешанного центрального момента системы через второй смешанный начальный момент и математические ожидания:

Это выражение часто применяется на практике при вычислении корреляционного момента аналогично тому, как для одной случайной величины дисперсия часто вычисляется через второй начальный момент и математическое ожидание.

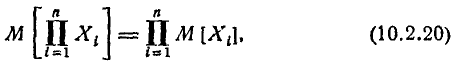

Теорема умножения математических ожиданий обобщается и на произвольное число сомножителей, только в этом случае для её применения недостаточно того, чтобы величины были некоррелированны, а требуется, чтобы обращались в нуль и некоторые высшие смешанные моменты, число которых зависит от числа членов в произведении. Эти условия заведомо выполнены при независимости случайных величин, входящих в произведение. В этом случае

т. е. математическое ожидание произведения независимых случайных величин равно произведению их математических ожиданий.

Это положение легко доказывается методом полной индукции.

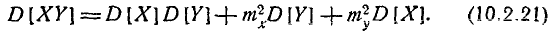

10.Дисперсия произведения независимых случайных величин

Докажем, что для независимых величин

X. У

Доказательство:

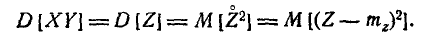

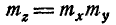

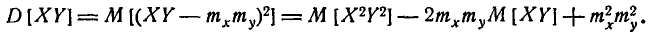

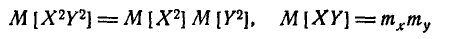

Обозначим XY = Z. По определению дисперсии

Так как величины X, У независимы,  и

и

При независимых X, У величины тоже независимы

тоже независимы  ; следовательно,

; следовательно,

и

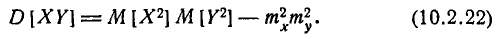

Но  есть не что иное, как второй начальный момент величины X, и, следовательно, выражается через дисперсию:

есть не что иное, как второй начальный момент величины X, и, следовательно, выражается через дисперсию:

аналогично

Подставляя эти выражения в формулу (10.2.22) и приводя подобные члены, приходим к формуле (10.2.21).

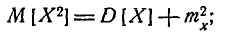

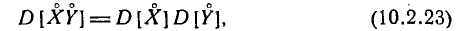

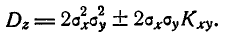

В случае, когда перемножаются центрированные случайные величины (величины с математическими ожиданиями, равными нулю), формула (10.2.21) принимает вид:

т. е. дисперсия произведения независимых центрированных случайных величин равна произведению их дисперсий:

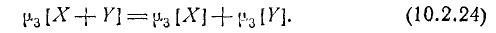

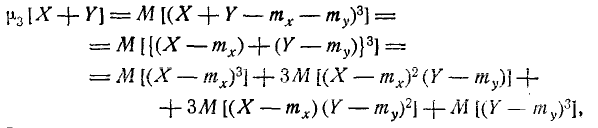

11. Высшие моменты суммы случайных величин

В некоторых случаях приходится вычислять высшие моменты суммы независимых случайных величин. Докажем некоторые относящиеся сюда соотношения.

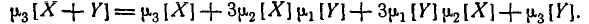

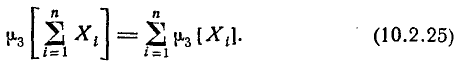

1) Если величины X, Y независимы, то

Доказательство:

Можно доказать, что любые функции от независимых случайных величин также независимы.

Можно доказать, что любые функции от независимых случайных величин также независимы.

откуда по теореме умножения математических ожиданий

Но первый центральный момент  для любой величины равен нулю; два средних члена обращаются в нуль, и формула (10.2.24) доказана. Соотношение (10.2.24) методом индукции легко обобщается на произвольное число независимых слагаемых:

для любой величины равен нулю; два средних члена обращаются в нуль, и формула (10.2.24) доказана. Соотношение (10.2.24) методом индукции легко обобщается на произвольное число независимых слагаемых:

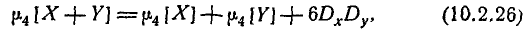

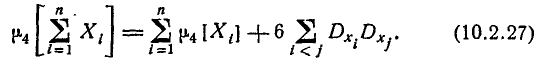

2) Четвёртый центральный момент суммы двух независимых случайных величин выражается формулой

где Dx, Dy— дисперсии величин X и Y.

Доказательство совершенно аналогично предыдущему.

Методом полной индукции легко доказать обобщение формулы (10.2.26) на произвольное число независимых слагаемых:

Аналогичные соотношения в случае необходимости легко вывести и для моментов более высоких порядков.

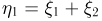

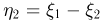

12. Сложение некоррелированных случайных векторов

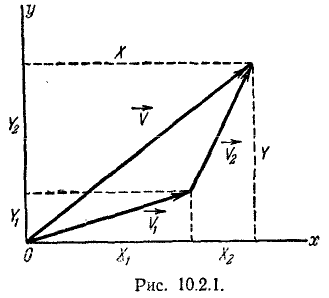

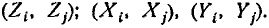

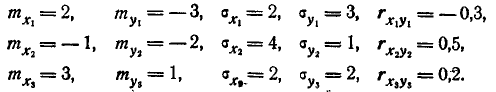

Рассмотрим на плоскости хОу два некоррелированных случайных вектора: вектор  с составляющими

с составляющими  и вектор

и вектор  с составляющими

с составляющими  (рис. 10.2.1).

(рис. 10.2.1).

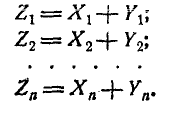

Рассмотрим их векторную сумму:

т. е. вектор с составляющими:

Требуется определить числовые характеристики случайного вектора  — математические ожидания

— математические ожидания  , дисперсии и корреляционный момент составляющих:

, дисперсии и корреляционный момент составляющих:

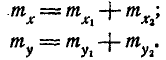

По теореме сложения математических ожиданий:

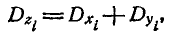

По теореме сложения дисперсий

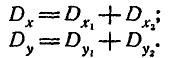

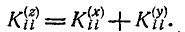

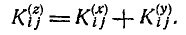

Докажем, что корреляционные моменты также складываются:

где  — корреляционные моменты составляющих каждого из векторов

— корреляционные моменты составляющих каждого из векторов  и

и  .

.

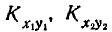

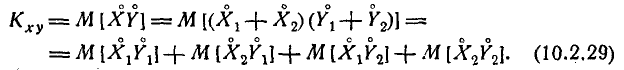

Доказательство. По определению корреляционного момента:

Так как векторы  некоррелированны, то два средних члена в формуле (10.2.29) равны нулю; два оставшихся члена представляют собой

некоррелированны, то два средних члена в формуле (10.2.29) равны нулю; два оставшихся члена представляют собой  и

и  формула (10.2.28) доказана.

формула (10.2.28) доказана.

Формулу (10.2.28) иногда называют «теоремой сложения корреляционных моментов».

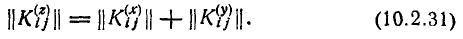

Теорема легко обобщается на произвольное число слагаемых. Если имеется две некоррелированные системы случайных величин, т. е. два n -мерных случайных вектора:

с составляющими

с составляющими

с составляющими

с составляющими

то их векторная сумма

имеет корреляционную матрицу, элементы которой получаются суммированием элементов корреляционных матриц слагаемых:

где  обозначают соответственно корреляционные моменты величин

обозначают соответственно корреляционные моменты величин

Формула (10.2.30) справедлива как при  так и при

так и при  Действительно; составляющие вектора

Действительно; составляющие вектора  равны:

равны:

По теореме сложения дисперсий

или в других обозначениях

По теореме сложения корреляционных моментов при

В математике суммой двух матриц называется матрица, элементы которой получены сложением соответствующих элементов этих матриц. Пользуясь этой терминологией, можно сказать, что корреляционная матрица суммы двух некоррелированных случайных векторов равна сумме корреляционных матриц слагаемых:

Это правило по аналогии с предыдущими можно назвать «теоремой сложения корреляционных матриц».

Применения теорем о числовых характеристиках

В данном п° мы продемонстрируем применение аппарата числовых характеристик к решению ряда задач. Некоторые из этих задач имеют самостоятельное теоретическое значение и найдут применение в дальнейшем. Другие задачи носят характер примеров и приводятся для иллюстрации выведенных общих формул на конкретном цифровом материале.

Задача:

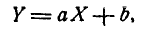

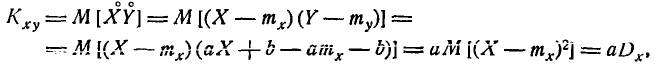

Коэффициент корреляции линейно зависимых случайных величин. Доказать, что если случайные величины X и Y связаны линейной функциональной зависимостью

то их коэффициент корреляции равен +1 или —1, смотря по знаку коэффициента а.

Решение:

Имеем:

где Dx — дисперсия величины X. Для коэффициента корреляций имеем выражение:

Для определения  найдём дисперсию величины У:

найдём дисперсию величины У:

Подставляя в формулу A0.3.1), имеем:

Величина  равна +1, когда а положительно, и —1, когда а отрицательно, что и требовалось доказать.

равна +1, когда а положительно, и —1, когда а отрицательно, что и требовалось доказать.

Задача:

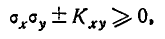

Границы коэффициента корреляции. Доказать, что для любых случайных величин

Решение:

Рассмотрим случайную величину:

где  — средние квадратические отклонения величин X, Y. Определим дисперсию величины Z. По формулe (10.2.13) имеем:

— средние квадратические отклонения величин X, Y. Определим дисперсию величины Z. По формулe (10.2.13) имеем:

или

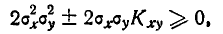

Так как дисперсия любой случайной величины не может быть отрицательна, то

или

откуда

следовательно

что и требовалось доказать.

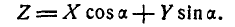

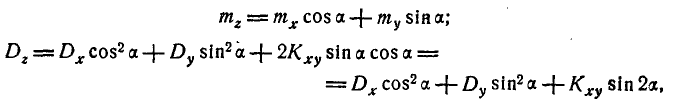

Задача:

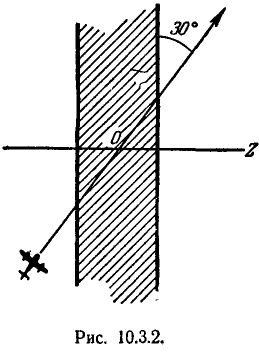

Проектирование случайной точки на плоскости на произвольную прямую

Дана случайная точка на плоскости с координатами (X, Y) (рис. 10.3.1). Спроектируем эту точку на ось Oz, проведённую через начало координат под углом а к оси Ох. Проекция точки (X, У) на ось Oz также есть случайная точка; её расстояние Z от начала координат есть случайная величина. Требуется найти атематическое ожидание и дисперсию величины Z.

Решение:

Имеем

Так как Z есть линейная функция аргументов X и Y, то

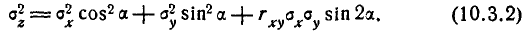

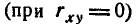

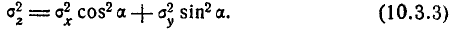

где  —дисперсии и корреляционный момент величин (X, Y). Переходя к средним квадратическим отклонениям, получим:

—дисперсии и корреляционный момент величин (X, Y). Переходя к средним квадратическим отклонениям, получим:

В случае некоррелированных случайных величин

Задача:

Математическое ожидание числа появлений события при нескольких опытах.

Производится п опытов, в каждом из которых может появиться или не появиться событие А. Вероятность появления события А і-м опыте равна  Найти математическое ожидание числа появлений события.

Найти математическое ожидание числа появлений события.

Решение:

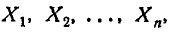

Рассмотрим прерывную случайную величину X — число появлений события во всей серии опытов. Очевидно,

где  — число появлений события в первом опыте,

— число появлений события в первом опыте,  — число появлений события во втором опыте,

— число появлений события во втором опыте,

— число появлений события в n -м опыте, или, короче,

— число появлений события в n -м опыте, или, короче,

где  —число появлений события в i-м опыте

—число появлений события в i-м опыте

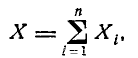

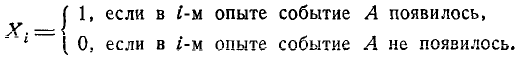

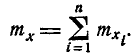

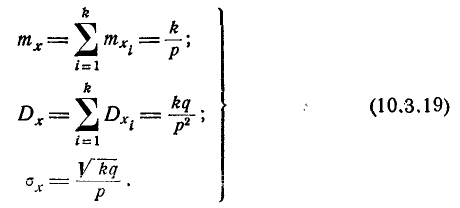

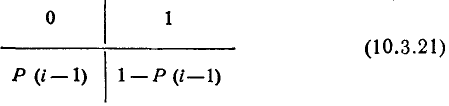

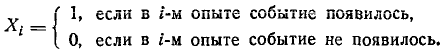

Каждая из величин  есть прерывная случайная величина с двумя возможными значениями: 0 и 1. Ряд распределения величины

есть прерывная случайная величина с двумя возможными значениями: 0 и 1. Ряд распределения величины  имеет вид:

имеет вид:

где  — вероятность непоявления события А в i-м опыте.

— вероятность непоявления события А в i-м опыте.

Иначе — характеристическая случайная величина события А в i-м опыте.

Иначе — характеристическая случайная величина события А в i-м опыте.

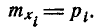

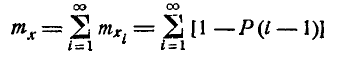

По теореме сложения математических ожиданий

где  —математическое ожидание величины

—математическое ожидание величины

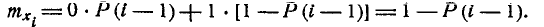

Вычислим математическое ожидание величины  По определению математического ожидания

По определению математического ожидания

Подставляя это выражение в формулу (10.3.5), имеем

т. е. математическое ожидание числа появлений события при нескольких опытах равно сумме вероятностей события в отдельных опытах.

В частности, когда условия опытов одинаковы и

формула (10.3.5) принимает вид

Так как теорема сложения математических ожиданий применима к любым случайным величинам — как зависимым, так и независимым, формулы (10.3.6) и (10.3.7) применимы к любым опытам—зависимым и независимым.

Выведенная теорема часто применяется в теории стрельбы, когда требуется найти среднее число попаданий при нескольких выстрелах— зависимых или независимых. Математическое ожидание числа попаданий при нескольких выстрелах равно сумме вероятностей попадания при отдельных выстрелах.

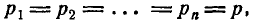

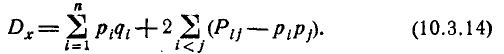

Задача:

Дисперсия числа появлений события при нескольких независимых опытах.

Производится п независимых опытов, в каждом из которых может появиться событие А, причём вероятность появления события А в i-м опыте равна  Найти дисперсию и среднее квадратическое отклонение числа появлений события А.

Найти дисперсию и среднее квадратическое отклонение числа появлений события А.

Решение:

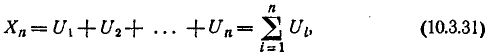

Рассмотрим случайную величину X — число появлений события А. Так же как d предыдущей задаче, представим величину X в виде суммы:

где  — число появлений события в i-м опыте.

— число появлений события в i-м опыте.

В силу независимости опытов случайные величины  независимы и к ним применима теорема сложения дисперсий:

независимы и к ним применима теорема сложения дисперсий:

Найдём дисперсию случайной величины  . Из ряда распределения (10.3.4) имеем:

. Из ряда распределения (10.3.4) имеем:

откуда

т. е. дисперсия числа появлений события при нескольких независимых опытах равна сумме вероятностей появления и непоявления события в каждом опыте.

Из формулы (10.3.8) находим среднее квадратическое отклонение числа появлений события А:

При неизменных условиях опытов, когда  формулы (10.3.8) и (10.3.9) упрощаются и принимают вид:

формулы (10.3.8) и (10.3.9) упрощаются и принимают вид:

Задача:

Дисперсия числа появлений события при зависимых опытах.

Производится п зависимых опытов, в каждом из которых может появиться событие А, причём вероятность события А в i-м опыте равна  Определить дисперсию числа появлений события.

Определить дисперсию числа появлений события.

Решение:

Для того чтобы решить задачу, снова представим число появлений события X в виде суммы:

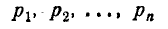

Так как опыты зависимы, то нам недостаточно задать вероятности

того, что событие А произойдёт в первом, втором, третьем и т. д. опытах. Нужно ещё задать характеристики зависимости опытов. Оказывается, для решения нашей задачи достаточно задать вероятности  совместного появления события А как в i-м, так и в j-м опыте:

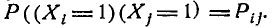

совместного появления события А как в i-м, так и в j-м опыте:  Предположим, что эти вероятности заданы. Применим к выражению (10.3.11) теорему о дисперсия суммы (формулу (10.2.10)):

Предположим, что эти вероятности заданы. Применим к выражению (10.3.11) теорему о дисперсия суммы (формулу (10.2.10)):

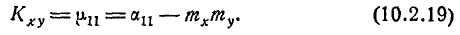

где  — корреляционный момент величин

— корреляционный момент величин

По формуле (10.2.19)

Рассмотрим случайную величину  . Очевидно она равна нулю, если хотя бы одна из величин

. Очевидно она равна нулю, если хотя бы одна из величин  равна нулю, т. е. хотя бы в одном из опытов (i-м или j-м) событие А не появилось. Для того чтобы величина

равна нулю, т. е. хотя бы в одном из опытов (i-м или j-м) событие А не появилось. Для того чтобы величина  была равна единице, требуется, чтобы в обоих опытах (i-м или j-м) событие А появилось. Вероятность этого равна

была равна единице, требуется, чтобы в обоих опытах (i-м или j-м) событие А появилось. Вероятность этого равна  . Следовательно,

. Следовательно,

и

Формула (10.3.14) и выражает дисперсию числа появлений события при зависимых опытах. Проанализируем структуру этой формулы. Первый член в правой части формулы представляет собой дисперсию числа появлений события при независимых опытах, а второй даёт «поправку на зависимость». Если вероятность  равна

равна  то эта поправка равна нулю. Если вероятность

то эта поправка равна нулю. Если вероятность  больше, чем

больше, чем  это значит, что условная вероятность появления события А в j-м опыте при условии, что в i-м опыте оно появилось, больше, чем простая (безусловная) вероятность появления события в j-м опыте

это значит, что условная вероятность появления события А в j-м опыте при условии, что в i-м опыте оно появилось, больше, чем простая (безусловная) вероятность появления события в j-м опыте  , (между появлениями события в i-м и j-м опытах имеется положительная корреляция). Если это так для любой пары опытов, то поправочный член в формуле (10.3.14) положителен и дисперсия числа появлений события при зависимых опытах больше, чем при независимых.

, (между появлениями события в i-м и j-м опытах имеется положительная корреляция). Если это так для любой пары опытов, то поправочный член в формуле (10.3.14) положителен и дисперсия числа появлений события при зависимых опытах больше, чем при независимых.

Если вероятность  меньше, чем

меньше, чем  (между появлениями события в i-м и j-м опытах существует отрицательная корреляция), то соответствующее слагаемое отрицательно. Если это так для любой пары опытов, то дисперсия числа появлений события при зависимых опытах меньше, чем при независимых.

(между появлениями события в i-м и j-м опытах существует отрицательная корреляция), то соответствующее слагаемое отрицательно. Если это так для любой пары опытов, то дисперсия числа появлений события при зависимых опытах меньше, чем при независимых.

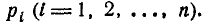

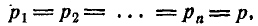

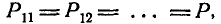

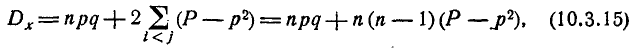

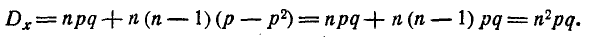

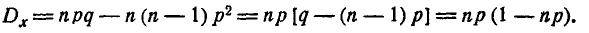

Рассмотрим частный случай, когда

т. е. условия всех опытов одинаковы. Формула (10.3.14) принимает вид:

т. е. условия всех опытов одинаковы. Формула (10.3.14) принимает вид:

где Р — вероятность появления события А сразу в паре опытов (все равно каких). В этом частном случае особый интерес представляют два подслучая: 1. Появление события А в любом из опытов влечёт за собой с достоверностью его появление в каждом из остальных. Тогда Р = р, и формула (10.3.15) принимает вид:

2. Появление события А в любом из опытов исключает его появление в каждом из остальных. Тогда Р = 0, и формула (10.3.15) принимает вид:

Задача:

Математическое ожидание числа объектов, приведённых в заданное состояние.

На практике часто встречается следующая задача. Имеется некоторая группа, состоящая из п объектов, по которым осуществляется какое-то воздействие. Каждый из объектов в результате воздействия может быть приведён в определённое состояние S (например, поражён, исправлен, обнаружен, обезврежен и т. п.). Вероятность того, что і-й объект будет приведён в состояние S, равна  Найти математическое ожидание числа объектов, которые в результате воздействия по группе будут приведены в состояние S .

Найти математическое ожидание числа объектов, которые в результате воздействия по группе будут приведены в состояние S .

Решение:

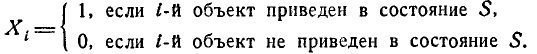

Свяжем с каждым из объектов случайную величину  , которая принимает значения 0 или 1:

, которая принимает значения 0 или 1:

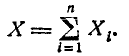

Случайная величина X — число объектов, приведённых в состояние S , — может быть представлена в виде суммы;

Отсюда, пользуясь теоремой сложения математических ожиданий, получим:

Математическое ожидание каждой из случайных величин  известно:

известно:

Следовательно,

т. е. математическое ожидание числа объектов, приведённых в состояние S, равно сумме вероятностей перехода в это состояние для каждого из объектов.

Особо подчеркнём, что для справедливости доказанной формулы вовсе не нужно, чтобы объекты переходили в состояние S независимо друг от друга. Формула справедлива для любого вида воздействия.

Задача:

Дисперсия числа объектов, приведённых в заданное состояние.

Если в условиях предыдущей задачи переход каждого из объектов в состояние S происходит независимо от всех других, то, применяя теорему сложения дисперсий к величине

получим дисперсию числа объектов, приведённых в состояние S:

Если же воздействие по объектам производится так, что переходы в состояние S для отдельных объектов зависимы, то дисперсия числа объектов, переведённых в состояние S, выразится формулой (см. задачу 6)

где  — вероятность того, что в результате воздействия i-й и j-й объекты вместе перейдут в состояние S.

— вероятность того, что в результате воздействия i-й и j-й объекты вместе перейдут в состояние S.

Задача:

Математическое ожидание числа опытов до k-го появления события.

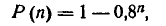

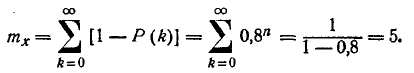

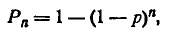

Производится ряд независимых опытов, в каждом из которых может с вероятностью р появиться событие А. Опыты проводятся до тех пор, пока событие А не появится k раз, после чего опыты прекращаются. Определить математическое ожидание, дисперсию и с. к. о. числа опытов X, которое будет произведено.

Решение:

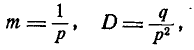

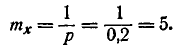

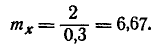

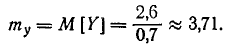

В примере 3 п° 5.7 были определены математическое ожидание и дисперсия числа опытов до первого появления события А:

где р— вероятность появления события в одном опыте, q = 1 — р — вероятность непоявления.

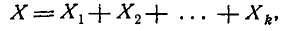

Рассмотрим случайную величину X — число опытов до k-ro появления события А. Её можно представить в виде суммы:

где  — число опытов до первого появления события А,

— число опытов до первого появления события А,  — число опытов от первого до второго появления события А (считая второе).

— число опытов от первого до второго появления события А (считая второе).

— число опытов от (k— 1)-го до k-ro появления события А (считая k-е).

— число опытов от (k— 1)-го до k-ro появления события А (считая k-е).